Guide d’achat des produits d’apprentissage basés sur l’IA

Comment utiliser ce guide

L’intelligence artificielle est devenue de plus en plus essentielle pour les équipes L&D qui cherchent à améliorer les programmes de formation, à engager les employés, à favoriser la réussite de l’organisation et à rester compétitives. Mais tous les produits d’apprentissage basés sur l’IA se valent-ils ? Probablement pas.

Alors, comment faire la différence entre ce qui relève du battage médiatique et ce qui est réellement utile ?

C’est là que ce guide intervient. Le Guide d’achat des produits d’apprentissage basés sur l’IA est destiné à aider les professionnels de la formation et du développement à naviguer dans le paysage de l’IA pour l’apprentissage, en offrant des informations précieuses et en vous aidant à prendre des décisions éclairées lors de l’achat de solutions d’IA pour vos initiatives de formation.

Que vous exploriez le potentiel de l’IA pour personnaliser les expériences d’apprentissage, automatiser les tâches administratives ou optimiser la diffusion de contenu, ce guide vous fournira une feuille de route pour identifier et sélectionner les outils d’IA qui s’alignent sur les besoins uniques de votre organisation en matière d’apprentissage et de développement.

Un paysage en évolution

L’IA devient rapidement une partie intégrante des entreprises. Selon des recherches récentes, 35 % des entreprises mondiales déclarent utiliser l’IA dans leurs activités.

Mais ce n’est pas seulement la disponibilité de l’IA (ou la nouveauté) qui est à l’origine de cette adoption rapide. L’IA devient rapidement une nécessité en raison, en partie, de deux macro-tendances qui ont un impact significatif sur la main-d’œuvre.

- La relation entre le taux de croissance de la population et le chômage

- L’évolution radicale des demandes et des attentes des équipes de formation et de développement.

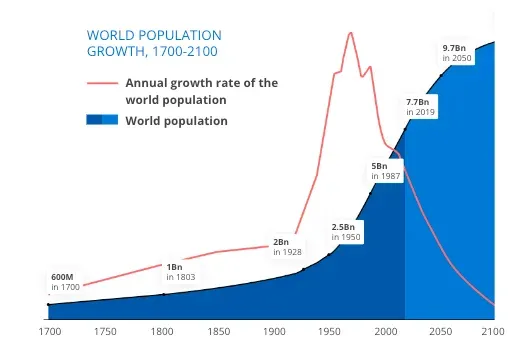

Commençons par le taux de croissance annuel de la population ou, plus précisément, son absence.

Les taux de natalité mondiaux ont chuté de façon spectaculaire. Selon The Economist, les 15 pays les plus importants (en termes de PIB) ont tous un taux de fécondité inférieur au taux de remplacement, ce qui signifie que les personnes vieillissent plus vite que nous ne pouvons les remplacer.

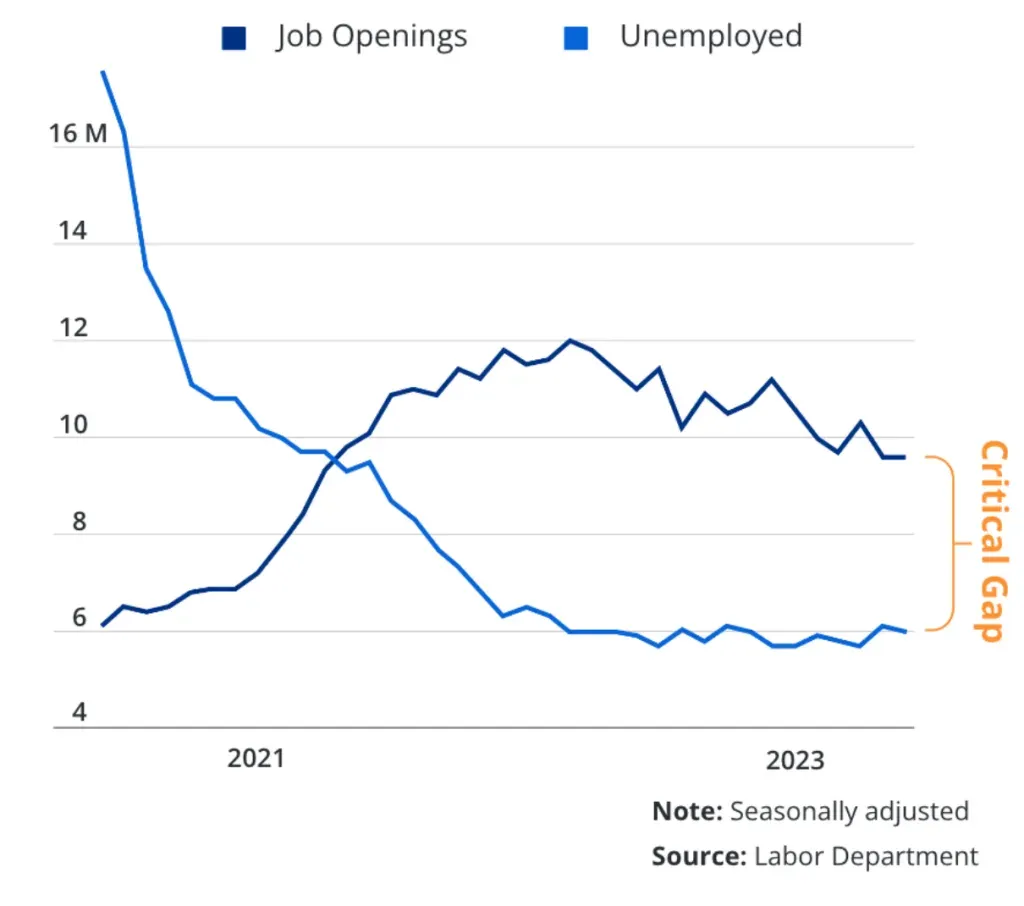

Autrefois, il y avait plus de chômeurs que d’offres d’emploi. Mais ces dernières années, ce paradigme s’est inversé, et on compte désormais plus d’emplois vacants que de personnes pour les pourvoir. Tout cela se traduit par une pénurie de main-d’œuvre, ce qui entraîne une concurrence accrue pour les travailleurs qualifiés.

Les données démographiques ne sont pas les seules à évoluer de manière spectaculaire. Le paysage de l’apprentissage change également.

Il s’est considérablement élargi.

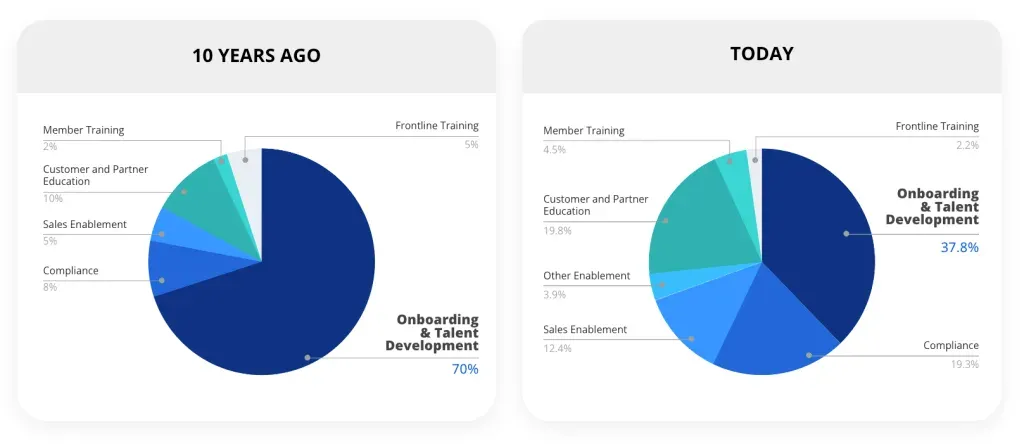

Il y a dix ans, la majorité des cas d’utilisation de la formation étaient internes (par exemple, l’intégration, le développement des talents, la conformité, etc.). Cela signifiait que moins de programmes étaient dispensés à un plus petit nombre d’apprenants. Aujourd’hui, de plus en plus d’organisations étendent l’apprentissage en dehors de l’entreprise. Les données clients internes de Docebo reflètent cette évolution.

Cette évolution n’est pas propre à notre organisation. Elle est révélatrice d’une tendance plus large. Des études, dont une récente du Brandon Hall Group, montrent que plus de 50 % des entreprises dispensent des formations à des groupes externes, non salariés. Il s’agit notamment des clients, des partenaires de chaîne, des distributeurs, des revendeurs à valeur ajoutée et des franchisés.

Une fois que la formation s’étend à l’extérieur de l’organisation, le nombre d’apprenants (ainsi que les programmes et le contenu nécessaires pour les soutenir) augmente de façon exponentielle.

La promesse de l’intelligence artificielle (IA)

Moins de personnes. Plus de travail. Telle est notre réalité actuelle. Et c’est en grande partie ce qui fait de l’IA une solution si attrayante.

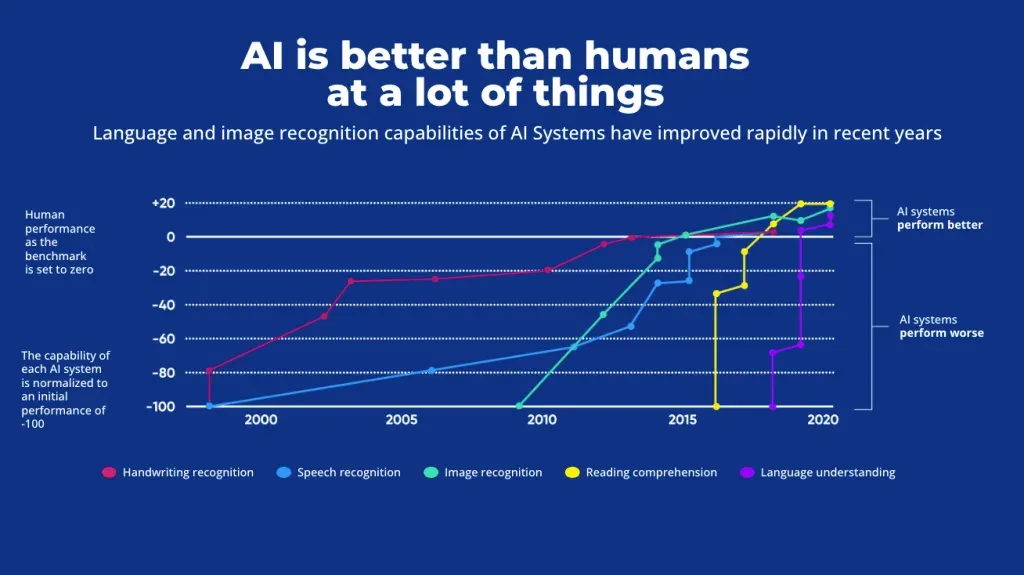

Comme le montre le diagramme ci-dessous, l’IA surpasse les performances humaines dans de nombreux domaines, notamment la reconnaissance d’images, la compréhension écrite et la compréhension du langage. Cela offre aux organisations une solution pour compenser les pénuries de talents, tout en augmentant l’efficacité en déchargeant une grande partie des tâches répétitives et non créatives.

Forrester prédit que les initiatives d’IA en entreprise stimuleront la productivité et la résolution créative de problèmes de 50 %. Non seulement l’intégration de l’IA dans l’entreprise peut contribuer à atténuer la pénurie de main-d’œuvre, mais elle peut également offrir un avantage concurrentiel. Selon les données de 2023, l ‘IA permet à un employé d’économiser 2,5 heures par jour en moyenne.

Bien que les solutions d’IA recèlent un grand potentiel et de nombreuses promesses, il est important de se rappeler qu’un produit d’IA utile pour une partie de l’entreprise pourrait ne pas l’être pour une autre. Par exemple, une solution de révision de contrats alimentée par l’IA pourrait augmenter la productivité et l’efficacité de votre équipe juridique, mais elle ne sera d’aucune grande utilité pour l’équipe de formation et développement. En d’autres termes, n’importe quelle solution d’IA ne fera pas l’affaire. Vous aurez besoin de produits d’IA ciblés dans toute votre organisation, et les équipes L&D auront besoin de solutions d’IA dédiées à l’apprentissage.

Le saviez-vous ?

En 2008, des développeurs ont créé une IA jouant aux échecs, appelée Stockfish, et lui ont enseigné les règles et les stratégies du jeu. À pleine puissance, il est pratiquement impossible pour un humain de gagner contre Stockfish. En décembre 2017, une IA concurrente appelée AlphaZero a été créée. La stratégie n’a jamais été enseignée à cette IA, qui s’est simplement entraînée en observant un nombre massif de parties d’échecs et en jouant des parties d’entraînement contre elle-même pendant quelques jours. À puissance de calcul égale pour chaque modèle, AlphaZero bat régulièrement Stockfish.

Qu’est-ce que l’IA pour l’apprentissage ?

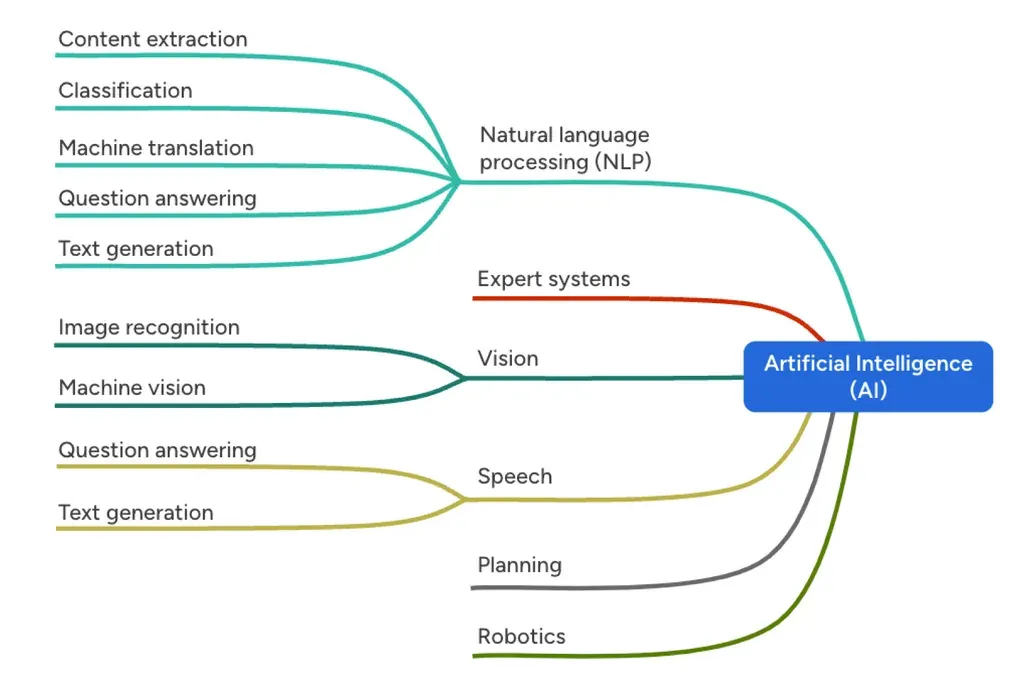

Lorsque nous parlons d’ »IA pour l’apprentissage » ou de « Learning AI », nous parlons de produits, de modèles et d’agents d’IA conçus spécifiquement pour aider les concepteurs pédagogiques, les équipes de formation et de perfectionnement et d’autres professionnels de l’apprentissage. Dans le contexte plus large de l’IA, les produits d’IA d’apprentissage d’aujourd’hui relèvent généralement des branches du traitement du langage naturel (NLP), de la parole et de la vision, qui font toutes appel à l’apprentissage automatique.

Lors de l’évaluation des solutions d’IA d’apprentissage, une manière plus utile et peut-être plus pratique de considérer l’IA pour apprentissage est de se pencher sur ce qu’elle fait, les tâches qu’elle peut accomplir. Plus précisément, quelles sont les tâches qu’elle peut accomplir et qui sont pertinentes pour votre organisation de formation et de développement. C’est là que réside la véritable opportunité.

Peut-être vous avez du mal à embaucher des concepteurs pédagogiques, de sorte que votre équipe prend du retard dans la création de contenu. Peut-être que les exigences de votre équipe dépassent votre capacité de production. Il se peut que votre équipe manque de compétences et qu’elle ne soit pas en mesure d’analyser les données. Ou encore, vous êtes en train de développer vos programmes ou votre entreprise et vous avez besoin de capacités de traduction. En fin de compte, une IA apprenante devrait vous aider à résoudre un problème particulier. Par conséquent, votre décision devrait être axée sur le problème, et non sur le produit.

Conseil

Une bonne approche consiste à traiter un achat potentiel d’IA comme vous traiteriez un candidat à un poste. (Vous n’achetez pas un produit ; vous recrutez une aide !) Vous n’embaucheriez pas quelqu’un simplement parce qu’il est bien habillé et disponible. Vous ne devriez donc pas acheter un produit d’IA parce qu’il est intelligent et attrayant. Comme les humains, les outils d’IA ont des limites. Avec les candidats, vous découvrez ces limites lors du processus d’entretien. L’évaluation du produit est l’occasion de déceler les limitations potentielles de l’IA et de vous assurer que vos processus incluent des contrôles et des mécanismes d’équilibre qui atténuent les risques associés à ces limitations.

Concepts de base de l’apprentissage de l’IA

Pour prendre une décision éclairée lors de l’achat de produits d’IA dans le learning, il convient de se familiariser avec quelques concepts de base.

01 Modèles d’IA

Un modèle d’IA est le composant central d’un système d’IA qui est responsable du traitement et de la prise de décision proprement dits. Il est conçu pour effectuer une tâche spécifique (par exemple, la reconnaissance d’images, la compréhension du langage naturel, la recommandation, etc.) Les modèles d’IA sont les moteurs de la solution. Ils prennent des données en entrée, les traitent et produisent un résultat, tel qu’une prédiction ou une classification.

Les modèles d’IA sont formés sur des ensembles de données massifs pour identifier les modèles et les informations pertinents pour leur tâche. La formation est un processus gourmand en ressources qui intervient généralement avant que le modèle ne soit déployé. Même les modèles d’IA les plus populaires aujourd’hui présentent des lacunes dans leurs données de formation.

Parce que les modèles d’IA peuvent être complexes, contenant de nombreux paramètres, couches et algorithmes (en particulier dans les modèles d’apprentissage profond comme les réseaux neuronaux), leur déploiement à l’échelle peut être gourmand en ressources et peut nécessiter un matériel puissant, ce qui fait grimper le coût de la génération de contenu pour chaque invite ou demande.

Heureusement, les modèles d’IA ne sont qu’une partie du paysage en constante évolution. La plupart des produits d’apprentissage de l’IA s’appuieront sur des stratégies et des technologies supplémentaires, comme les agents d’IA, pour améliorer les modèles d’IA généraux et proposer des solutions plus spécialisées, plus puissantes et plus agiles.

02 Les agents d’IA

Un agent d’intelligence artificielle désigne un programme spécialisé alimenté par l’IA et conçu pour fonctionner de manière autonome tout en étant influencé par les entrées de l’utilisateur. Les agents IA s’appuient sur des modèles de langage à grande échelle, comme ceux utilisés par le GPT d’OpenAI (et d’autres), pour comprendre l’intention d’un utilisateur avant d’accomplir des tâches et d’atteindre des objectifs. Les agents peuvent s’adapter à de nouvelles informations ou à des changements dans le scénario dans lequel leur tâche est basée.

Contrairement aux modèles d’IA traditionnels, qui sont généralement statiques et limités aux tâches pour lesquelles ils ont été explicitement programmés, les agents d’IA sont dynamiques et flexibles. En outre, ils peuvent avoir accès à des outils (tels que la capacité d’interroger une source de données ou d’interagir avec d’autres modèles d’IA) qu’ils décident de manière autonome d’utiliser ou non, et à quel moment.

Les agents IA sont conçus avec un degré d’autonomie qui leur permet d’opérer dans des environnements imprévisibles ou changeants. Ils peuvent prendre des décisions, modifier leur cours d’action et même apprendre des résultats de ces décisions. Cette capacité d’adaptation est cruciale dans des domaines comme la robotique (comme les voitures auto-conduites), où les agents doivent naviguer dans des environnements réels, ou dans des environnements d’apprentissage virtuels pour des tâches telles que les interactions avec les apprenants, où ils interagissent avec les humains dans des conversations fluides et souvent imprévisibles. Une caractéristique clé qui différencie les agents de l’IA des modèles est leur capacité à s’engager dans des comportements orientés vers un but.

Ils ne se contentent pas de traiter et de répondre aux entrées, mais travaillent activement à la réalisation d’objectifs. Lorsque nous réfléchissons aux possibilités d’apprentissage adaptatif et personnalisé, les agents d’IA joueront probablement un rôle énorme en travaillant directement avec les apprenants, en s’adaptant aux lacunes d’apprentissage qui sont identifiées par les interactions avec l’agent d’IA.

Dans le contexte de l’apprentissage, un agent d’IA peut être conçu pour se concentrer sur la remédiation lorsqu’il soutient les membres de l’équipe qui sont en difficulté. Il peut alimenter des scénarios virtuels de chat ou de jeu de rôle vidéo qui créent un espace sûr pour une pratique répétée, avec un partenaire qui ne se fatigue jamais et qui peut s’adapter à mesure que les apprenants s’améliorent. Dans les cas où l’optimisation est centrale, un agent d’IA peut être formé pour se spécialiser dans l’agrégation et la compréhension de grands ensembles de données et rechercher des opportunités de resserrer les processus ou les étapes vers un objectif final ou un ICP. Si l’accent est mis sur la maîtrise ou la certification, des agents d’IA peuvent être développés pour guider les apprenants à travers les étapes d’apprentissage vers une véritable compétence, en utilisant des cadres pédagogiques solides comme la taxonomie de Bloom ou la planification à rebours.

Comme c’est le cas pour toutes les interactions avec l’IA, les agents, leur travail et leurs résultats doivent être surveillés et contextualisés par des humains, en particulier dans les scénarios et les tâches à fort enjeu.

Niveaux d’automatisation de la conception pédagogique.

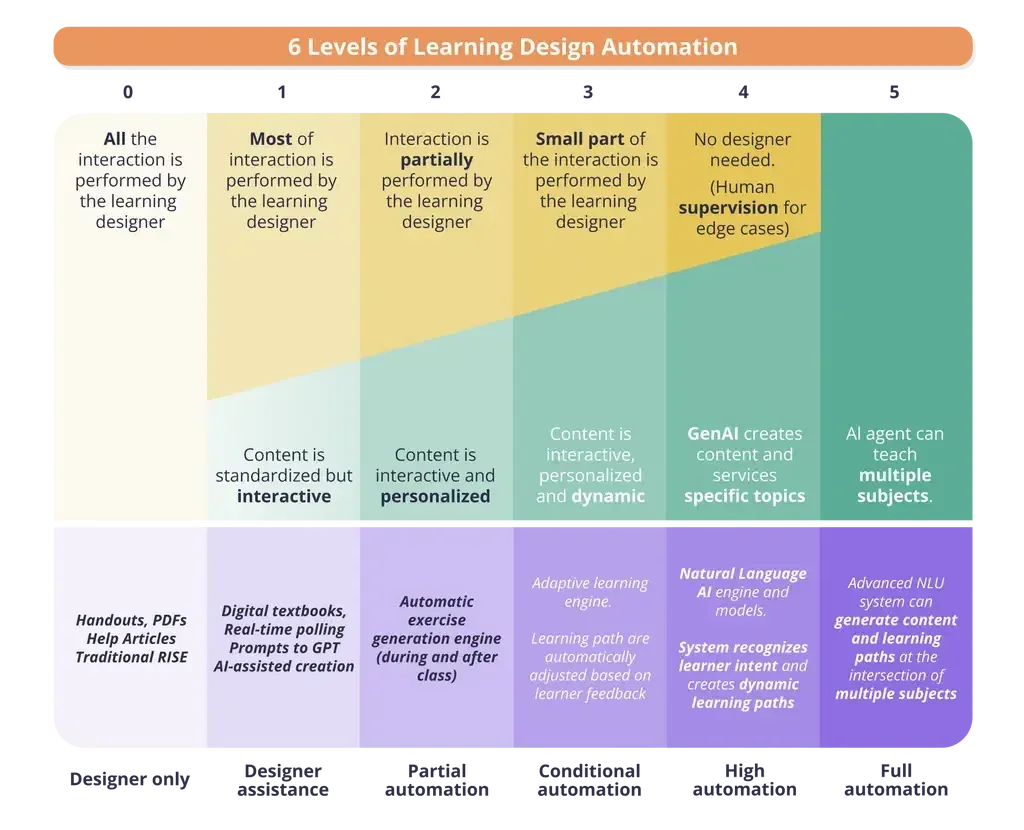

À mesure que vous introduisez l’IA dans votre organisation, il est important de réfléchir à l’intersection entre l’IA et la conception pédagogique pilotée par l’humain. Comme l’illustre le tableau, à mesure que vous cherchez à atteindre des niveaux d’automatisation plus élevés, il existe une échelle mobile entre l’humain et la machine en ce qui concerne les questions de contrôle, de personnalisation et de résultats.

À gauche, vous avez une main de fer sur le système que vous utilisez. Les actions et les décisions sont prises par le concepteur du contenu ou de l’enseignement, et les améliorations et l’automatisation apportées par l’IA sont au mieux limitées. Cependant, à mesure que vous vous déplacez sur l’échelle vers la droite, un plus grand degré d’action et de prise de décision est laissé au système d’IA. En retour, vous bénéficiez d’une scalabilité et d’une personnalisation beaucoup plus poussées, d’une automatisation, d’un gain de temps et d’une évolutivité de votre programme d’apprentissage.

Les avantages d’une automatisation plus poussée vont au-delà des éléments énumérés ci-dessus. Pour la plupart des produits d’une entreprise, il existe toujours une certaine quantité de tâches manuelles et répétitives qui nuisent à la productivité. Il peut s’agir de résumer ou de réorganiser des données. Il peut s’agir de rédiger des questions de quiz. Il peut s’agir de la fois où vous avez dû passer des heures et des heures à ré-étiqueter des métadonnées parce qu’elles avaient faussé une table.

La corvée est une partie invisible et insidieuse de votre vie professionnelle que l’intelligence artificielle peut gérer facilement. Si vous passez 20 % de votre journée à vous débattre avec des tâches fastidieuses, l’IA peut vous aider à récupérer ce temps et à prendre de l’avance, ou, parfois, simplement à rattraper votre retard.

Rien de tout cela ne se produit au niveau 1 du tableau ci-dessus. Pour retrouver votre temps et déléguer à l’IA, vous devez d’abord comprendre le problème que vous essayez de résoudre, puis trouver une solution (comme la curation de contenu alimentée par l’apprentissage automatique, l’analyse de données, la cartographie des compétences basée sur l’IA ou les outils de création de contenu de l’IA générative) qui répond à ce problème.

En parlant d’IA générative, le moment serait bien choisi pour déballer ce qu’elle est et comment elle fonctionne à haut niveau.

L’IA générative (GenAI) expliquée

Avant l’IA générative, l’intelligence artificielle se spécialisait généralement dans la reconnaissance et la prédiction de choses. Il pouvait s’agir de transformer les gribouillis d’un document scanné en texte éditable, ou de prendre un fichier audio et de transcrire des mots à partir des ondes sonores. Sur les claviers des smartphones, des types d’intelligence artificielle de base peuvent tenter de prédire ou de deviner votre prochain mot. Avec l’IA générative cependant, l’intelligence artificielle crée des choses basées sur des modèles qu’elle reconnaît dans les données sources.

Le saviez-vous ?

L’IA générative est capable d’écrire un sonnet dans le style de William Shakespeare. Shakespeare était incroyablement cohérent, et le fait qu’il ait apposé son nom sur la plupart des sonnets qu’il a écrits n’y est pas étranger. La GenAI peut également créer des œuvres d’art dans le style de Vincent Van Gogh. Cela ouvre un large éventail de possibilités passionnantes, mais aussi des considérations éthiques autour du droit d’auteur des artistes dont les œuvres finissent par être utilisées dans ces modèles d’IA sans consentement explicite.

À la base, l’IA générative s’appuie sur des modèles d’apprentissage profond (deep learning) pour étudier de vastes bibliothèques de données. Cela peut inclure toutes les images et tous les textes écrits du domaine public, tous les réseaux sociaux accessibles au public, les articles de presse, et bien plus encore. À mesure que les entreprises d’IA intègrent davantage de données dans leurs modèles, la précision et la fiabilité de ces modèles augmentent. En assimilant les données, elle commence à reconnaître des schémas. Ces schémas peuvent inclure des éléments que les humains tiennent pour acquis, ou que nous avons l’impression de simplement savoir.

Il peut s’agir de la façon dont la lumière est censée rebondir sur l’œil d’une personne dans une photographie. Il peut s’agir de la structure prévisible des noms et des verbes dans la plupart des phrases. Il peut même s’agir de la bonne façon de prononcer « accent ». Ce sont les types de modèles auxquels nous ne pensons pas consciemment, mais que nous reconnaissons immédiatement si quelque chose n’est pas conforme à nos attentes. Après s’être entraînée sur des millions, voire des milliards de documents, d’images et de vidéos, il s’avère que l’IA peut également reconnaître ces schémas, surtout si tout ce que vous lui avez donné est cohérent dans la manière dont elle fait ces choses.

L’IA générative interprète la cohérence de ces schémas comme une attente de ce que les humains font et s’attendent à voir. À bien des égards, elle veut simplement nous donner ce que nous voulons. Nous devons simplement être intentionnels quant aux données utilisées pour entraîner l’IA, au moment où elle traite tout cela, et à la fin de tout cela, nous obtenons souvent quelque chose de très, très proche de ce que nous attendions ou aurions pu faire nous-mêmes.

Voici un conseil

Vous ne savez pas si l’image que vous regardez est réelle ou générée par l’IA ? S’il s’agit d’une personne, regardez ses mains. Les données de référence pour les mains sont généralement limitées dans les modèles de génération d’images non spécialisés et c’est souvent l’une des premières choses qui semblent incorrectes ou bizarres. Si une image comporte du texte ou des logos, examinez-la de plus près pour voir s’ils ne semblent pas naturels. Le texte généré par l’IA peut apparaître pixellisé ou étiré, et les logos peuvent être altérés.

Difficultés potentielles liées aux solutions IA

L’IA peut parfois donner l’impression d’être de la magie. Vous pouvez obtenir des résultats sans savoir ni comprendre comment l’IA y est parvenue. Ce n’est pas acceptable. Nous ne sommes pas au pays d’Oz. Nous devons prêter attention à ce qui se passe derrière le rideau ou, dans le cas de l’IA, à ce qui se passe à l’intérieur de la boîte noire.

01 Le problème de la boîte noire

Comme l’a souligné le philosophe français Bruno Latour, « plus la science et la technologie réussissent, plus elles deviennent opaques et obscures ». C’est particulièrement vrai pour l’apprentissage automatique, où souvent même les concepteurs de l’IA ne peuvent pas expliquer pourquoi ou comment l’IA est arrivée à une décision.

Ce manque de visibilité est appelé « le problème de la boîte noire ». Il fait référence au défi de comprendre et d’interpréter les processus de prise de décision des modèles complexes d’apprentissage automatique, car ils fonctionnent souvent avec des mécanismes internes complexes qui sont difficiles à expliquer ou à prédire.

Quelques aspects clés sont au cœur du problème de la boîte noire :

Manque de transparence : les réseaux neuronaux profonds qui alimentent l’IA générative, par exemple, sont constitués de nombreuses couches et paramètres (souvent des milliards). Il est souvent difficile de comprendre comment chaque paramètre influence le résultat final. (Même si le système s’expliquait de lui-même, vous n’auriez pas le temps de comprendre son processus décisionnel avant de mourir). Ce manque de transparence fait qu’il est difficile de déterminer comment le modèle est parvenu à une décision spécifique.

Complexité : les modèles d’apprentissage automatique peuvent capturer des modèles et des relations complexes dans les données, mais ces modèles peuvent être trop complexes pour être compris par l’homme. Les modèles pourraient utiliser des caractéristiques ou des connexions qui ne sont pas immédiatement évidentes pour les humains (comme des biais implicites ou des omissions inhérentes aux données collectées).

Difficulté de dépannage : lorsqu’un modèle d’IA commet une erreur ou prend une décision biaisée, il peut être difficile d’en identifier la cause profonde, ce qui entraîne des difficultés de débogage et d’amélioration du système.

Préoccupations éthiques : Dans certaines applications où l’IA est utilisée pour prendre des décisions critiques (comme la finance, la santé ou les questions juridiques), le problème de la boîte noire soulève des préoccupations éthiques. Les parties prenantes ne devraient pas faire confiance aux décisions prises par des modèles qu’elles ne peuvent pas interpréter ou expliquer.

La résolution du problème de la boîte noire est un domaine de recherche et de développement en cours dans le domaine de l’IA. Les chercheurs travaillent sur des méthodes visant à améliorer l’interprétabilité et la transparence des modèles, notamment en créant des techniques permettant de visualiser le comportement des modèles, l’importance des caractéristiques et les justifications des décisions. Cela est particulièrement important pour garantir l’équité, la responsabilité et la transparence des systèmes d’IA dans les applications du monde réel. (Nous approfondirons ce point dans la section « Cadres pour une IA performante »).

02 Hallucinations

L’IA a beaucoup progressé. Mais elle est loin d’être parfaite.

Les modèles d’IA peuvent générer ou produire des informations, du contenu ou des résultats qui ne sont pas basés sur des données réelles ou des connaissances du monde réel. C’est ce qu’on appelle une hallucination, qui peut aller d’incohérences mineures à des inexactitudes factuelles, en passant par des fabrications complètes. Parce qu’elles sont généralement cohérentes et grammaticalement correctes, les hallucinations peuvent être très convaincantes et peuvent être prises pour des faits ou crues exactes.

Les hallucinations dans les modèles d’IA peuvent survenir en raison de divers facteurs, notamment des erreurs ou des biais dans les données d’entraînement, la complexité du modèle, un manque de contrôle et de supervision pendant l’entraînement, ou l’invite elle-même. Dans le traitement du langage naturel, par exemple, les modèles de langage génèrent parfois un texte qui semble cohérent, mais qui est entièrement fabriqué et dépourvu de base factuelle. Par exemple, un modèle de langage peut générer un paragraphe de texte qui décrit un événement ou un scénario fictif comme s’il était réel.

03 Les biais dans l’IA

Les biais dans l’IA font référence à la présence de préjugés injustes et inéquitables dans les décisions ou les prédictions faites par les systèmes d’intelligence artificielle. Ces préjugés peuvent provenir de diverses sources et conduire à des résultats discriminatoires ou inégaux.

Même si les enjeux ne sont pas aussi importants dans l’apprentissage que dans le domaine de la santé ou la justice pénale, ils peuvent néanmoins nuire à vos programmes et se manifester de la manière suivante :

Biais dans les données d’entraînement : l’une des principales sources de biais dans l’IA est la partialité des données d’entraînement. Si les données utilisées pour former un modèle d’IA contiennent des biais (historiques, d’échantillonnage, de procuration, etc.) ou reflètent les inégalités et les stéréotypes sociétaux existants, le modèle est susceptible d’apprendre et de perpétuer ces biais. Concevoir un système de manière à ce qu’il produise des exemples équilibrés en termes de genre (indépendamment de la répartition existante entre les genres dans tous les exemples sur lesquels il a été formé) permettrait de contrecarrer ce phénomène.

Biais algorithmique : certains algorithmes peuvent favoriser un groupe ou produire des résultats biaisés en raison de la manière dont ils traitent les données. Un système de reconnaissance faciale, par exemple, peut être moins précis pour les personnes à la peau plus foncée, ou un système de reconnaissance vocale peut ne pas fonctionner aussi bien avec les dialectes régionaux.

Biais d’étiquetage : les personnes chargées de l’étiquetage peuvent inconsciemment introduire leurs préjugés lorsqu’elles marquent des images ou du texte. Comme nous l’avons vu plus haut, l’IA veut simplement répondre aux attentes des humains telles qu’elles sont définies par les schémas des données sources. Par conséquent, tous les préjugés représentés dans le marquage humain se retrouveront dans les résultats du système d’IA basés sur les statistiques. L’IA a appris à avoir exactement le même degré de partialité qu’un humain, ce qui peut être problématique.

Boucles de rétroaction : l’IA n’apprend pas seulement à partir de son ensemble de données, mais aussi à partir de l’interaction qu’elle a avec les humains. Si les utilisateurs s’engagent systématiquement avec des contenus biaisés ou leur fournissent des commentaires positifs, le système d’IA peut s’adapter et renforcer ces biais. En d’autres termes, les systèmes d’IA qui interagissent avec les utilisateurs peuvent apprendre des préjugés à partir des interactions avec les utilisateurs.

Dans le contexte de l’IA pour l’apprentissage, les préjugés constituent un risque énorme dont il faut être conscient. Il n’y a pas deux apprenants identiques. Il existe un niveau de mise en œuvre efficace de l’IA qui apporte un degré de personnalisation basé sur ce qui est unique chez chaque apprenant, tout en tirant parti des données disponibles au sein de votre plateforme de formation. La combinaison de ces deux stratégies peut permettre à l’IA de s’adapter aux besoins d’un apprenant à un niveau individuel.

Il est essentiel d’atténuer les préjugés dans l’IA pour l’apprentissage pour s’assurer que les systèmes soient équitables, éthiques et impartiaux dans leur prise de décision et que l’expérience d’apprentissage est personnalisée en fonction de l’individu (et non pas avec des préjugés à son encontre).

Le saviez-vous ?

Selon une récente enquête, 86 % des utilisateurs interrogés ont été victimes d’hallucinations de l’IA lorsqu’ils utilisent des chatbots comme ChatGPT et Bard. Malgré cela, 72 % d’entre eux continuent de faire confiance à l’IA.

Cadres pour une IA réussie

Il n’existe pas de solution miracle au problème de la boîte noire, aux hallucinations, aux préjugés et aux autres problèmes inhérents à l’IA, mais heureusement, un certain nombre de personnes et d’organisations intelligentes travaillent sur ce problème. En développant des solutions alimentées par l’IA, l’équipe Docebo a creusé dans ses propres recherches et a trouvé ces principes, techniques et cadres utiles pour réfléchir à des solutions efficaces, centrées sur l’apprenant et fiables.

01 Inspectable, explicable, modifiable

Dans le rapport de l’Office of Educational Technology du ministère américain de l’éducation, IA and the Future of Teaching and Learning, les auteurs créent des critères pour les « bons modèles d’IA » et introduisent l’idée qu’une IA efficace pour l’apprentissage doit avoir trois caractéristiques : Elle doit pouvoir être inspectée, expliquée et supprimée.

L’inspectabilité : il s’agit de la capacité d’un utilisateur à contrôler les rouages internes de la manière dont l’IA prend des décisions et crée des résultats.

Explicabilité : capacité à fournir des explications lisibles par l’homme sur les décisions prises par les modèles d’IA.

Possibilité d’annulation : capacité de l’utilisateur à remplacer ou à supprimer des éléments de la production ou de la prise de décision d’une IA afin d’exercer un plus grand contrôle sur la production finale.

Ensemble, ces principes de développement de produits IA fournissent la transparence et le contrôle dont les humains ont besoin pour pouvoir valider et adapter les décisions du modèle IA, si nécessaire. Si un utilisateur est censé céder le contrôle de ses actions et de ses décisions à l’automatisation, ces principes permettent de préserver le contrôle global sur les résultats du système. Il est donc possible de bénéficier de l’IA sans devoir avoir une confiance aveugle dans le système.

02 Génération augmentée par récupération (RAG)

Une autre façon pour les développeurs d’améliorer la fiabilité des résultats d’un modèle d’IA est d’utiliser une stratégie appelée Retrieval Augmented Generation (RAG).

RAG est un cadre IA qui utilise une base de connaissances fiable pour améliorer les grands modèles de langage (LLM). Il récupère des faits précis pour améliorer le processus de génération et s’assurer que le contexte est fondé sur les informations les plus récentes.

Rappelez-vous : les paramètres et les données initialement introduits dans un modèle IA sont statiques, et pour les mettre à jour, le modèle doit être réentraîné. La RAG permet aux modèles de langage d’éviter le réentraînement et de donner accès à des informations actualisées et fiables. Cette approche renforce non seulement la fiabilité des informations fournies, mais réduit également la probabilité de créer des contenus faux ou trompeurs, ce qui en fait une technique précieuse pour les applications où l’exactitude des faits et le contexte sont primordiaux.

Les systèmes d’IA pour l’apprentissage les plus efficaces et les plus personnalisés se connecteront à la base de connaissances interne et externe de votre entreprise et en tireront parti pour s’assurer que le contenu d’apprentissage est non seulement complet, mais aussi spécifique à votre entreprise. Mais pour que cela soit efficace, vous devez mettre de l’ordre dans votre maison car, comme le dit l’adage, il faut savoir se débarrasser de ses déchets.

Remettre l’accent sur la gestion des connaissances

La plupart des professionnels de la formation et du développement comprennent déjà l’importance vitale de la gestion des connaissances, pourtant, cela peut parfois ressembler à une bataille difficile de construire un alignement interfonctionnel à travers votre entreprise autour de ce qui est essentiellement un projet à l’échelle de l’entreprise.

La qualité des résultats d’un modèle IA dépend de la qualité des données. Et lorsque les données référencées par RAG et votre solution IA sont les bases de connaissances internes et externes de votre entreprise, la gestion des connaissances devient essentielle pour tous les membres de l’organisation.

La base de connaissances référencée sert d’épine dorsale à la vérification des faits et à la validation, permettant au modèle de générer des informations précises et fiables. Si cette base de connaissances (les connaissances de votre organisation) est ancienne, incomplète ou inexacte, le processus RAG peut conduire à la diffusion d’informations incorrectes ou obsolètes.

Si vous investissez dans un produit d’IA qui fera référence à votre base de connaissances, la gestion des connaissances sera essentielle pour garantir la qualité et la pertinence des résultats.

Envisagez de constituer (ou de reconstituer) une équipe interfonctionnelle autour de la gestion des connaissances dans votre entreprise. Votre équipe devrait impliquer les groupes suivants, et toute autre personne unique à votre entreprise qui est essentielle pour définir les vérités :

- Produits

- Marketing produit

- Juridique

- Enablement (habilitation)

- Gestion des connaissances / équipe du service d’assistance

03 Atténuation des risques par la pédagogie

Disons, par exemple, que vous adoptez une IA pour l’apprentissage dont le modèle a été formé sur la majorité de l’internet et des cours gratuits (et peut-être quelques cours premium) disponibles sur le marché. Vous devez vous poser quelques questions embarrassantes :

- Ces cours sont-ils même bons, ou valables d’un point de vue pédagogique ?

- Les données d’entraînement et les modèles qui filent l’IA représentent-ils la barre que j’ai fixée pour mes programmes d’apprentissage ?

- Peut-on jamais savoir si un cours est efficace sans voir également comment les apprenants se sont comportés et ont retenu par la suite ?

En ce qui concerne l’IA pour l’apprentissage, la plus grande force de l’IA générative peut également représenter l’une de ses plus grandes vulnérabilités. Lorsqu’un modèle se fie aux schémas présents dans ses données d’entraînement, il ne peut pas prendre de décisions riches en contexte qui contredisent ces schémas. Posséder une bibliothèque de théories d’apprentissage ne fait pas de vous un praticien de l’apprentissage ni un maître animateur.

Sans comprendre également les résultats spécifiques de l’apprenant après un programme de formation, la compréhension de l’IA générative basée sur des modèles pour créer du contenu d’apprentissage repose uniquement sur le fait qu’un cours est théoriquement efficace, et la plupart des professionnels L&D savent à quelle vitesse un programme d’apprentissage peut déraper lorsque l’apprenant n’est pas au centre de sa conception.

Quand la pédagogie rencontre l’IA

Un modèle ou un cadre pédagogique intégré est la clé de voûte d’une IA pour la formation efficace. Il comble le fossé entre les capacités technologiques de l’IA et l’efficacité pédagogique en alignant le modèle d’IA sur les théories et pratiques pédagogiques établies. Il fournit les principes fondamentaux et les cadres nécessaires à la création d’expériences pédagogiques efficaces, attrayantes et percutantes. Ce qui est important, car plus l’expérience d’apprentissage a d’impact, plus la formation aura d’impact sur votre entreprise. (Car, comme nous le savons tous, l’apprentissage n’est pas seulement un facteur de croissance personnelle, il est aussi un facteur de croissance commerciale).

L’intégration de stratégies pédagogiques peut améliorer la qualité de l’expérience de formation en fournissant un contenu d’apprentissage adapté, aligné sur les objectifs, engageant, mesurable et personnalisé, et en guidant les processus de l’IA pour s’assurer que les objectifs d’apprentissage sont atteints de manière efficace et efficiente.

04 Systèmes « human-in-the-loop » (HILT)

Il existe probablement un certain nombre de tâches à faible enjeu que nous devrions entièrement confier à l’intelligence artificielle, sans jamais regarder en arrière. Nous l’avons toujours fait avec la technologie. (Plus personne ne fait fonctionner manuellement le standard téléphonique de la ville, n’est-ce pas ?)

Toutefois, un certain nombre de tâches et de fonctions importantes nécessiteront toujours la présence d’un être humain dans la boucle (HILT). Si nous sortons du cadre de la formation pour nous intéresser à quelque chose d’aussi fondamentalement important que l’alimentation, nous constatons que l’IA est déjà présente dans l’agriculture. De la détection des mauvaises herbes à l’analyse de la croissance en passant par la surveillance de la santé, les modèles d’apprentissage automatique contribuent à augmenter et à améliorer la façon dont nous cultivons les aliments et nourrissons notre population. Mais cela ne signifie pas que nous n’avons pas ou que nous n’aurons plus besoin des agriculteurs pour prendre ces décisions cruciales sur des systèmes essentiels. L’apprentissage est tout aussi essentiel et, quelles que soient les améliorations spectaculaires de l’intelligence artificielle, il nécessitera toujours un système humain dans la boucle.

Les systèmes d’IA font des prédictions et prennent des décisions, mais ils le font rarement avec une confiance de 100 % ou une certitude absolue. En fait, le concept de certitude absolue est très humain. C’est pourquoi les systèmes et processus HILT (Human-in-the-Loop) sont essentiels. Nous jouons un rôle central dans la gestion des nuances et des facteurs contextuels que l’IA ne saisit pas entièrement, ce qui permet d’atteindre un équilibre entre les données d’information générées par l’IA et la sagesse humaine.

Les solutions d’IA les plus puissantes n’élimineront pas le besoin d’interaction humaine. Elles la faciliteront à chaque étape afin que nous puissions valider et superviser le résultat (dans le contexte plus large dans lequel le modèle d’IA opère), fournir des commentaires et des instructions, et appliquer un jugement éthique et moral à la décision.

Le saviez-vous ?

Andragogie ou pédagogie ? L’andragogie fait référence aux meilleures pratiques et aux méthodes fondées sur la recherche pour enseigner aux apprenants adultes, et la pédagogie fait généralement référence aux meilleures pratiques et aux méthodes fondées sur la recherche pour enseigner aux enfants. Cependant, la pédagogie est souvent utilisée dans un contexte large pour décrire des méthodes destinées aux adultes comme aux enfants (par exemple, les collèges et les universités utilisent souvent la pédagogie plutôt que l’andragogie). Lorsque nous utilisons le terme pédagogie, c’est au sens large et nous reconnaissons que nos apprenants sont des adultes.

Des processus humains aux cadres IA

Que vous travailliez dans le graphisme, la création ou la conception pédagogique, il y a un processus créatif derrière votre métier. Ces processus sont reproductibles, situationnels et fondamentaux pour les types d’artefacts que vous créez. Ils peuvent également être reproduits et entraînés par une IA afin d’améliorer votre flux de travail, ce qui vous permet de vous concentrer à nouveau sur la prise de décisions stratégiques à plus grande échelle. Moins de travail, plus de productivité.

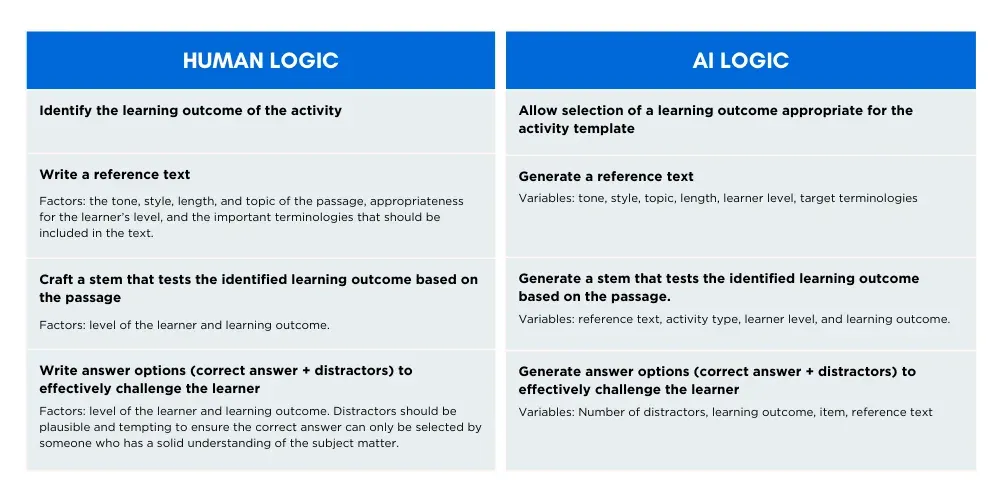

Le diagramme ci-dessous examine une façon de traduire certaines des décisions stratégiques qu’un concepteur pédagogique prend en rédigeant des questions à choix multiples en un cadre que l’IA peut suivre pour fournir des résultats similaires ou améliorés en une fraction du temps.

Lors de la rédaction des QCM, les concepteurs pédagogiques prennent en compte un grand nombre de facteurs différents qui affectent la qualité de l’évaluation.

En utilisant la méthodologie de Docebo, nous capturons tous ces facteurs et les utilisons comme variables d’entrée pour générer un résultat qui incarne toutes ces décisions humaines. Notez que la séquence des décisions est également conforme à l’ordre dans le processus de création humain et aux dépendances de chaque décision. Par exemple, lors de la création d’une activité de compréhension de la lecture, les créateurs rédigent d’abord un texte de référence, puis le sujet (la question) et enfin les options. C’est exactement l’ordre dans lequel les chaînes d’invites seront exécutées dans le processus de génération.

L’IA d’apprentissage d’aujourd’hui a toujours besoin d’être encadrée par l’auteur. À ce titre, les produits d’apprentissage les plus efficaces auront des méthodologies humaines (comme celle illustrée ci-dessus) derrière eux pour leur permettre de penser et de prendre des décisions comme un concepteur pédagogique.

Prochaines étapes

Maintenant que vous en savez plus sur l’IA pour l’apprentissage, vous êtes prêt à commencer vos recherches. Mais, avant de commencer, nous vous suggérons de répondre à ces six questions pour vous guider, vous et votre équipe, dans l’évaluation des fournisseurs potentiels et l’achat de produits d’apprentissage basés sur l’IA.

6 grandes questions auxquelles il faut répondre avant de s’engager avec des fournisseurs.

- Qu’est-ce qui motive votre décision d’achat ? L’acquisition de ce produit est-elle basée sur la résolution d’un problème existant, ou disposez-vous d’un budget résiduel et la démo était brillante ?

- Quel sera l‘impact sur l’expérience de l’utilisateur ? Ce produit s’appuie-t-il sur le comportement existant des utilisateurs ou attend-il d’eux qu’ils acquièrent de nouvelles compétences ? (Et qu’est-ce que cela signifie pour l’intégration et le délai de rentabilité ?)

- Qui contrôle les données et les processus ? Qui décide quelles données sont pertinentes pour le modèle IA ? Où vos données seront-elles stockées et traitées ?

- Comment éviterez-vous le problème de la boîte noire ? Pouvez-vous inspecter, expliquer ou annuler les décisions du modèle d’IA, si nécessaire ?

- L’apprentissage est-il au cœur du modèle d’IA ? Est-ce que la reconnaissance de schémas guidera la création de matériel pédagogique, ou est-ce que des stratégies pédagogiques efficaces sont intégrées pour guider les processus de l’IA ?

- Comment allez-vous gérér ce produit ? Les produits d’intelligence artificielle dépendent de la qualité de leurs données d’entrée. Comment allez-vous vous assurer que le contenu qu’ils consomment est réel, pertinent et fiable ?

À propos de Docebo IA

Nous sommes convaincus que l’intelligence artificielle offre l’une des opportunités d’innovation les plus puissantes dans le domaine de la formation et du développement. En tant que leaders dans ce secteur, nous ne suivons pas les tendances, nous les créons. La plateforme d’apprentissage de Docebo est propulsée par l’intelligence artificielle, avec plusieurs fonctionnalités d’IA intégrées dans l’ensemble du système pour améliorer la façon dont les entreprises déploient, gèrent et adaptent leurs programmes de formation.

Voici quelques principes directeurs sur la façon dont nous envisageons l’IA dans nos produits et services, et ce que vous pouvez attendre de l’IA de Docebo.

Une approche axée sur la pédagogie : Lorsqu’il s’agit d’apprentissage et de développement, un cadre IA qui n’inclut pas la pédagogie et les meilleures pratiques établies en matière d’enseignement et d’apprentissage ne suffira tout simplement pas. Notre équipe de produits IA comprend des experts en pédagogie qui utilisent une approche axée sur la pédagogie d’abord pour concevoir nos solutions IA afin de maximiser les résultats des apprenants tout en minimisant les hallucinations et les résultats inexacts.

Évaluation continue : Nous construisons un cercle vertueux d’apprentissage et d’évaluation continus et robustes pour informer nos modèles d’IA. Lorsque les modèles d’IA se basent uniquement sur la reconnaissance et la reproduction de schémas, les résultats ne sont pas adaptés au contenu d’apprentissage. En comprenant et en exploitant la performance des apprenants grâce à une évaluation intégrée, le flux d’apprentissage n’est jamais interrompu et une perspective plus complète est maintenue. L’IA de Docebo est connectée à l’ensemble du contexte et fournit l’épine dorsale fondamentale d’un apprentissage hyper-personnalisé.

Tendre vers un apprentissage individualisé : L’hyper-personnalisation et l’apprentissage dans le flux de travail sont des conséquences inéluctables de l’IA dans la formation. Chez Docebo, nous nous concentrons sur la livraison de ces éléments à nos clients grâce à une mise en œuvre intelligente d’une IA sûre et efficace.et efficace.

Inspectable, explicable, dérogatoire : une solution efficace d’IA pour l’apprentissage ne supprime jamais les humains du processus et de ses résultats. Chez Docebo, nous concevons avec l’inspectabilité, l’explicabilité et l’annulabilité au cœur de nos produits et services, permettant à l’utilisateur d’être en contrôle et d’avoir confiance en son travail.

Vous libérer pour vous concentrer sur ce qui compte : L’intention de Docebo est de concevoir des solutions d’apprentissage basées sur l’IA qui déchargent une grande partie du travail répétitif et chronophage, afin que les concepteurs pédagogiques puissent se concentrer sur ce qui compte vraiment, comme l’interprétation des données, la gouvernance du contenu, la prise de décision stratégique et la conception pédagogique holistique.

Vous donner le contrôle : Les organisations devraient avoir le contrôle sur la manière dont l’IA fonctionne au sein de leur entreprise. Les solutions de Docebo offrent aux entreprises le contrôle sur leurs propres données afin qu’elles puissent décider comment (et si) elles sont utilisées. Nous assurons également l’anonymisation des données sur notre propre grand modèle de langage (LLM) pour garantir la confidentialité et le contrôle des données.

Les contributeurs

Michael Chong

Senior Data Scientist (Docebo)

Rebecca Chu

Machine Learning Analyst (Docebo)

Vince De Freitas

Product Marketing Manager, Content & AI (Docebo)

Maija Mickols

AI Product Manager (Docebo)

Giuseppe Tomasello

Vice President of AI (Docebo)

Renée Tremblay

Senior Content Marketing Manager, (Docebo)