Guida all’acquisto di prodotti per l’apprendimento dell’IA

Come utilizzare questa guida

L’intelligenza artificiale (IA) è diventata sempre più essenziale per i team L&D che cercano di migliorare i programmi di formazione, coinvolgere i dipendenti, guidare il successo organizzativo e rimanere competitivi. Ma i prodotti per l’apprendimento dell’IA sono tutti uguali? Probabilmente no.

Quindi, come si fa a distinguere tra ciò che è un’illazione e ciò che è effettivamente utile?

È qui che entra in gioco questa guida. La Guida all’acquisto di prodotti per l’apprendimento dell’IA ha lo scopo di assistere i professionisti L&D nella loro navigazione nel panorama dell’IA per l’apprendimento, offrendo preziosi approfondimenti e aiutandovi a prendere decisioni informate quando considerate l’acquisto di soluzioni di IA per le vostre iniziative di apprendimento.

Sia che stiate esplorando il potenziale dell’IA per personalizzare le esperienze di apprendimento, automatizzare le attività amministrative o ottimizzare la distribuzione dei contenuti, questa guida vi fornirà una tabella di marcia per identificare e selezionare gli strumenti di IA che si allineano con le esigenze uniche di apprendimento e sviluppo della vostra organizzazione.

Il panorama in evoluzione

L’IA sta rapidamente diventando parte integrante del business. Secondo una recente ricerca, il 35% delle aziende globali riferisce di utilizzare l’IA nella propria attività.

Ma non è solo la disponibilità dell’IA (o la novità) a guidare questa rapida adozione. L’IA sta rapidamente diventando una necessità, in parte a causa di due macro-tendenze che stanno avendo un impatto significativo sulla forza lavoro.

- Il rapporto tra il tasso di crescita della popolazione e la disoccupazione

- Il drastico cambiamento delle richieste e delle aspettative dei team L&D.

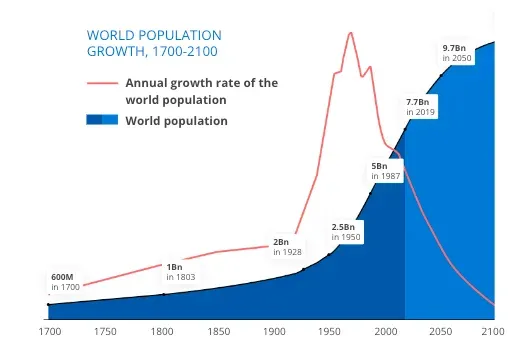

Partiamo dal tasso di crescita annuale della popolazione – o, più precisamente, dalla sua mancanza.

I tassi di natalità globali sono diminuiti drasticamente. Secondo l’Economist, i 15 Paesi più grandi (in base al PIL) hanno tutti un tasso di fertilità inferiore al tasso di sostituzione, il che significa che le persone escono dalla forza lavoro più velocemente di quanto si riesca a sostituirle.

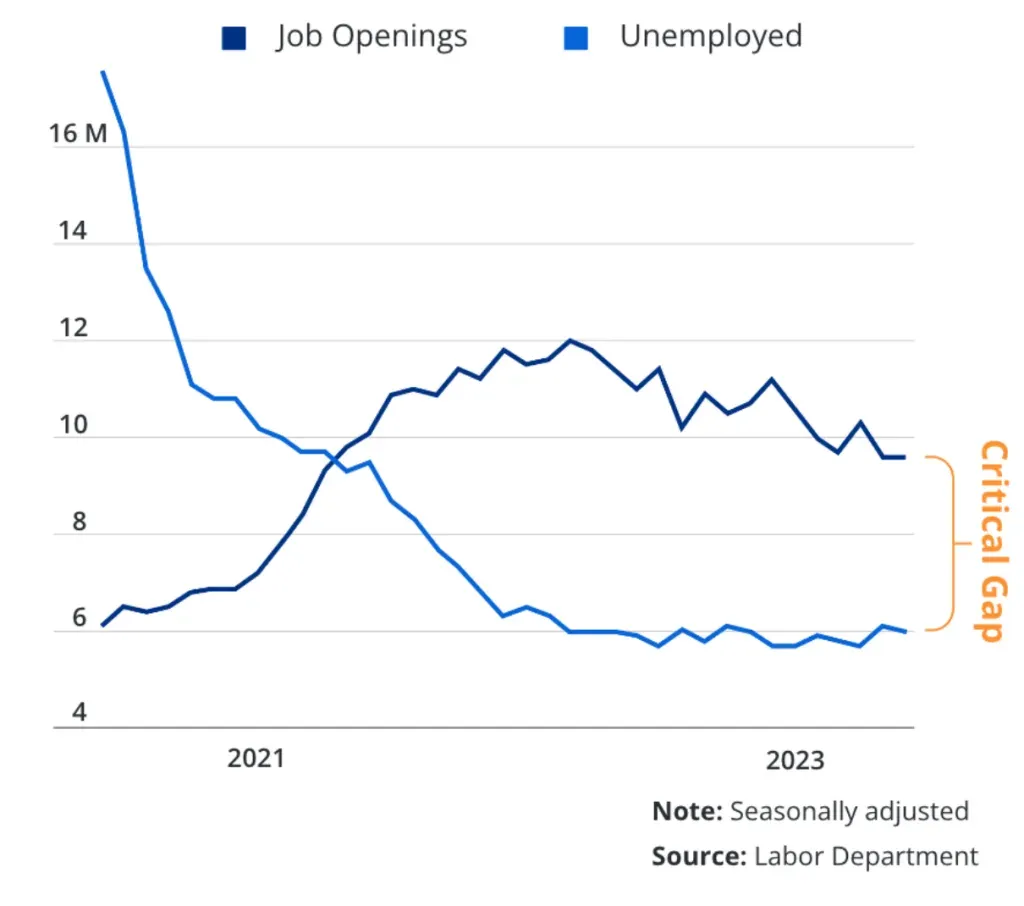

Un tempo c’erano più disoccupati che posti di lavoro disponibili. Ma negli ultimi anni il paradigma si è invertito e ora ci sono più posti di lavoro aperti che persone che li compilano. Tutto ciò si traduce in una carenza di manodopera, che porta a una maggiore concorrenza per i lavoratori di competenza.

La demografia non è l’unica cosa che si sta evolvendo in modo drammatico. Anche il panorama dell’apprendimento sta cambiando.

È diventato molto più grande.

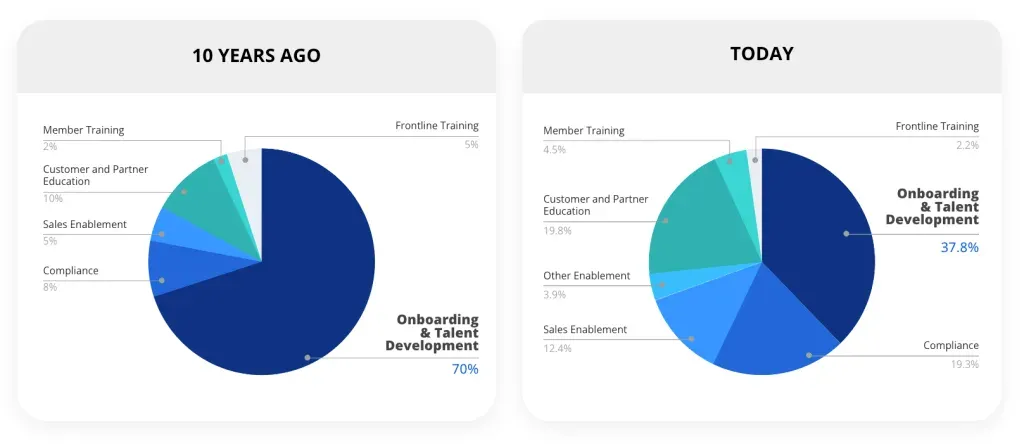

Dieci anni fa, la maggior parte dei casi di utilizzo della formazione era interna (ad esempio, onboarding, sviluppo dei talenti, conformità, ecc.) Ciò significava un numero minore di programmi erogati a un numero minore di utenti. Oggi, un numero maggiore di organizzazioni sta estendendo la formazione al di fuori dell’azienda. I dati dei clienti interni di Docebo riflettono questa evoluzione.

Non si tratta di un fenomeno esclusivo della nostra organizzazione. È indicativo di una tendenza più ampia. Studi, tra cui uno recente di Brandon Hall Group, mostrano che più del 50% delle organizzazioni offre formazione a gruppi esterni, non dipendenti. Questi includono clienti, partner di canale, distributori, rivenditori a valore aggiunto e franchisee.

Una volta che la formazione si estende al di fuori dell’organizzazione, il numero di utenti (insieme ai programmi e ai contenuti necessari per supportarli) cresce in modo esponenziale.

La promessa dell’intelligenza artificiale (IA)

Meno persone. Più lavoro. Questa è la nostra realtà attuale. Ed è una parte importante di ciò che rende l’IA una soluzione così attraente.

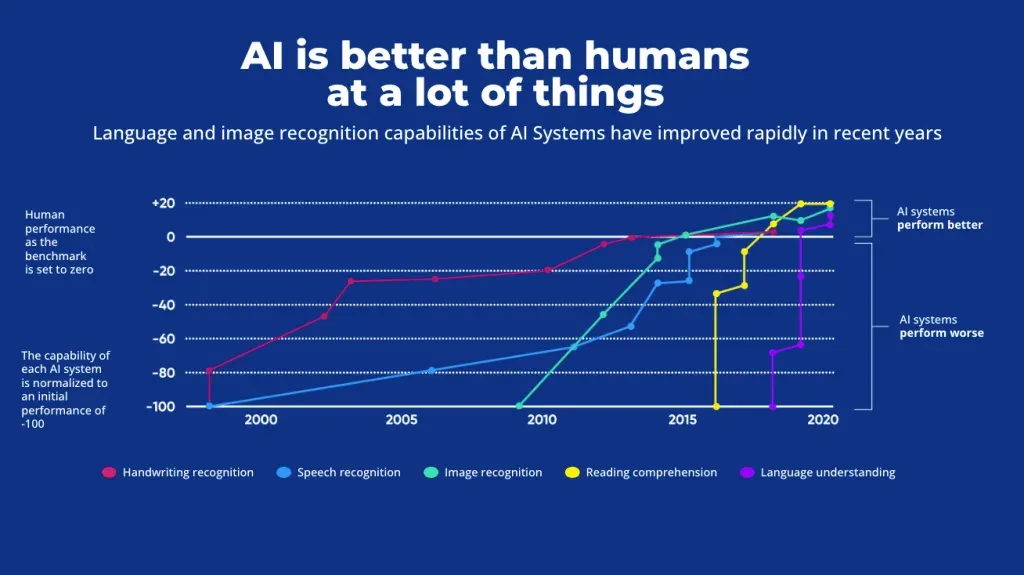

Come mostra il diagramma sottostante, l’IA sta superando le prestazioni umane in molte aree, tra cui il riconoscimento delle immagini, la comprensione della lettura e la comprensione del linguaggio. Questo rappresenta per le aziende una soluzione per compensare la carenza di talenti, aumentando al contempo l’efficienza grazie allo scarico di molte attività ripetitive e poco creative.

Forrester prevede che le iniziative di IA a livello aziendale aumenteranno la produttività e la risoluzione creativa dei problemi del 50%. L’integrazione dell’IA nell’azienda non solo può contribuire a mitigare la carenza di manodopera, ma può anche offrire un vantaggio competitivo. Secondo i dati di 2023, l ‘IA fa risparmiare in media 2,5 ore al giorno a un dipendente.

Anche se le soluzioni di IA hanno un grande potenziale e promesse, è importante ricordare che un prodotto di IA per una parte dell’azienda potrebbe non essere utile per un’altra. Ad esempio, una soluzione di revisione dei contratti alimentata dall’IA potrebbe aumentare la produttività e l’efficienza del team legale, ma non aiuterà molto il team di apprendimento e sviluppo. In altre parole, non basta una soluzione IA qualsiasi. Avrete bisogno di prodotti di IA orientati allo scopo in tutta l’organizzazione e i team L&D avranno bisogno di soluzioni di IA per l’apprendimento.

Lo sapevate che

Nel 2008 gli sviluppatori hanno creato un’IA che gioca a scacchi, chiamata Stockfish, e le hanno insegnato le regole e le strategie del gioco. Se funziona a pieno regime, è quasi impossibile per un essere umano vincere contro Stockfish. Nel dicembre 2017 è stata creata un’IA concorrente chiamata AlphaZero. A questa IA non è mai stata insegnata la strategia, ma si è semplicemente allenata osservando un numero enorme di partite di scacchi e giocando partite di prova contro se stessa per alcuni giorni. A parità di potenza di calcolo, AlphaZero batte costantemente Stockfish.

Che cos’è l’IA per l’apprendimento?

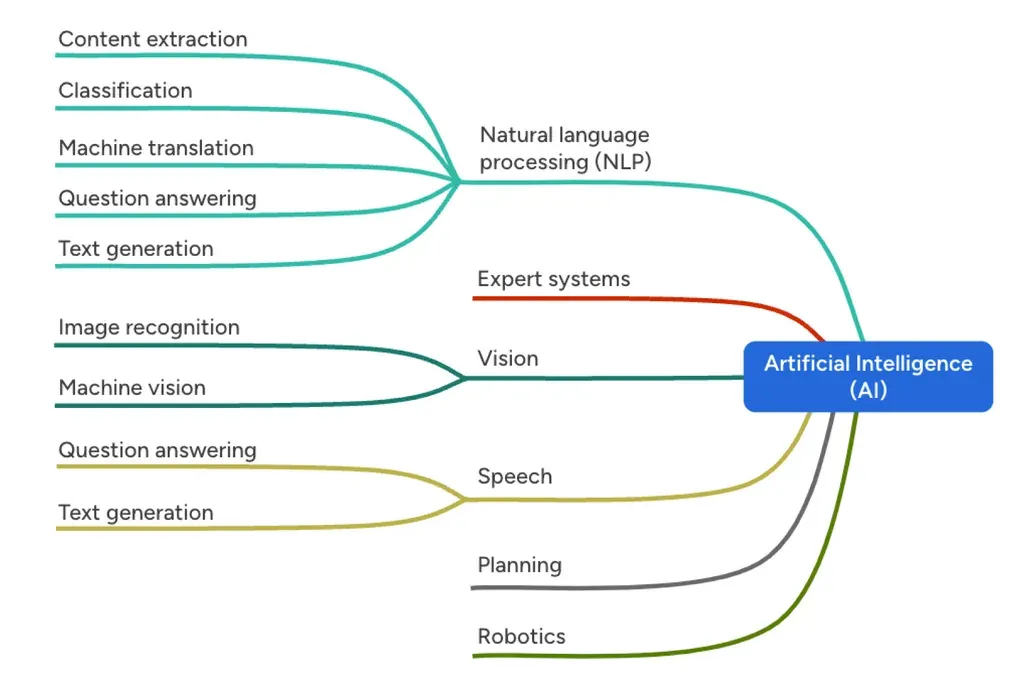

Quando parliamo di “IA per l’apprendimento” o “IA per l’apprendimento”, parliamo di prodotti, modelli e agenti di IA creati appositamente per supportare i progettisti didattici, i team L&D e altri professionisti dell’apprendimento. Nel contesto più ampio dell’IA, gli attuali prodotti di IA per l’apprendimento rientrano generalmente nei rami dell’elaborazione del linguaggio naturale (NLP), del parlato e della visione, che fanno tutti uso dell’apprendimento automatico.

Nella valutazione delle soluzioni di IA per l’apprendimento, un modo più utile e forse pratico di guardare all’IA per l’apprendimento è in termini di ciò che fa: i compiti che può svolgere. In particolare, quali compiti può svolgere che siano rilevanti per la vostra organizzazione L&D. È qui che si trova la vera opportunità. È qui che si trova la vera opportunità.

Forse avete difficoltà ad assumere designer didattici e quindi il vostro team è in ritardo nella creazione di contenuti. Forse le richieste del vostro team superano la vostra capacità di produzione. Potreste avere una carenza di competenze nel vostro team, quindi non siete in grado di analizzare i dati. O forse state scalando i vostri programmi o la vostra attività e avete bisogno di capacità di traduzione. In definitiva, l’IA dovrebbe aiutarvi a risolvere un problema particolare. Pertanto, la decisione deve essere guidata dal problema, non dal prodotto.

Ecco un consiglio

Un buon approccio consiste nel trattare un potenziale acquisto di IA come se si trattasse di un candidato al lavoro. (Non state acquistando un prodotto, ma un aiuto!) Non assumereste qualcuno solo perché è ben vestito e disponibile. Quindi non dovreste acquistare un prodotto IA solo perché è intelligente e brillante. Come gli esseri umani, gli strumenti di IA hanno dei limiti. Con i candidati, si scoprono questi limiti durante il processo di colloquio. La valutazione del prodotto è l’occasione per scoprire i potenziali limiti dell’IA e assicurarsi che i processi includano controlli e contrappesi che riducano i rischi associati a tali limiti.

Concetti di base dell’apprendimento dell’IA

Per prendere una decisione informata quando si acquistano prodotti di apprendimento informale, è necessario conoscere alcuni concetti di base.

01 Modelli di IA

Un modello di IA è il componente centrale di un sistema di IA, responsabile dell’elaborazione e del processo decisionale. È progettato per eseguire un compito specifico (ad esempio, riconoscimento di immagini, comprensione del linguaggio naturale, raccomandazioni, ecc.) I modelli di IA sono i motori delle soluzioni. Prendono i dati in ingresso, li elaborano e producono un risultato, come una previsione o una classificazione.

I modelli di IA vengono addestrati su enormi serie di dati per identificare modelli e informazioni rilevanti per il loro compito. L’addestramento è un processo ad alta intensità di risorse che in genere avviene prima dell’implementazione del modello. Anche i modelli di IA più diffusi oggi presentano lacune nei dati di addestramento.

Poiché i modelli di IA possono essere complessi e contenere numerosi parametri, livelli e algoritmi (in particolare nei modelli di apprendimento profondo come le reti neurali), la loro implementazione su scala può richiedere un notevole dispendio di risorse e un hardware potente, con un conseguente aumento dei costi di generazione dei contenuti per ogni richiesta o domanda.

Fortunatamente i modelli di IA sono solo una parte del panorama in continua evoluzione. La maggior parte dei prodotti per l’apprendimento dell’IA sfrutterà strategie e tecnologie aggiuntive, come gli agenti di IA, per migliorare i modelli generali di IA e offrire soluzioni più specializzate, potenti e agili.

02 Agenti di IA

Un agente di intelligenza artificiale si riferisce a un programma specializzato alimentato dall’IA e progettato per operare autonomamente, pur essendo influenzato dall’input dell’utente. Gli agenti di IA sfruttano modelli di linguaggio di grandi dimensioni, come quelli utilizzati da GPT di OpenAI (e altri), per comprendere le intenzioni dell’utente prima di portare a termine compiti e obiettivi. Gli agenti possono adattarsi a nuove informazioni o a cambiamenti nello scenario in cui si svolge il loro compito.

A differenza dei modelli di IA tradizionali, che sono generalmente statici e limitati ai compiti per i quali sono stati esplicitamente programmati, gli agenti di IA sono dinamici e flessibili. Inoltre, possono avere accesso a strumenti (come la possibilità di interrogare una fonte di dati o di interagire con altri modelli IA) che decidono autonomamente se e quando utilizzare.

Gli agenti IA sono progettati con un grado di autonomia che permette loro di operare in ambienti imprevedibili o mutevoli. Possono prendere decisioni, modificare il loro corso d’azione e persino imparare dai risultati di queste decisioni. Questa adattabilità è fondamentale in campi come la robotica (come le auto a guida autonoma), dove gli agenti devono navigare in ambienti reali, o in ambienti di apprendimento virtuale per compiti come le interazioni con gli utenti, dove interagiscono con gli esseri umani in conversazioni fluide e spesso imprevedibili. Una caratteristica chiave che differenzia gli agenti IA dai modelli è la loro capacità di impegnarsi in comportamenti orientati agli obiettivi.

comportamenti orientati agli obiettivi. Non solo elaborano e rispondono agli input, ma attivano anche il raggiungimento degli obiettivi. Se pensiamo alle opportunità di apprendimento adattivo e personalizzato, gli agenti di IA svolgeranno probabilmente un ruolo importante nel lavorare direttamente con gli utenti, adattandosi alle lacune di apprendimento identificate attraverso le interazioni con l’agente di IA.

Nel contesto dell’apprendimento, un agente IA può essere progettato per concentrarsi sul recupero quando supporta i membri del team che sono fuori strada. Può alimentare scenari virtuali di chat o video roleplay che creano uno spazio sicuro per la pratica ripetuta, con un utente che non si stanca mai e che può adattarsi al miglioramento degli allievi. Nei casi in cui l’ottimizzazione può essere centrale, un agente IA può essere addestrato per specializzarsi nell’aggregazione e nella comprensione di grandi insiemi di dati e cercare opportunità per rafforzare i processi o le fasi verso un obiettivo finale o un KPI. Se l’obiettivo è la padronanza o la certificazione, gli agenti di IA possono essere sviluppati per guidare gli utenti attraverso le fasi di apprendimento verso la vera competenza, utilizzando framework pedagogicamente validi come la tassonomia di Bloom o la progettazione a ritroso.

Come nel caso di tutte le interazioni con l’IA, gli agenti, il loro lavoro e i loro risultati devono essere monitorati e contestualizzati dagli esseri umani, soprattutto negli scenari e nei compiti ad alto rischio.

Livelli di automazione della progettazione dell’apprendimento

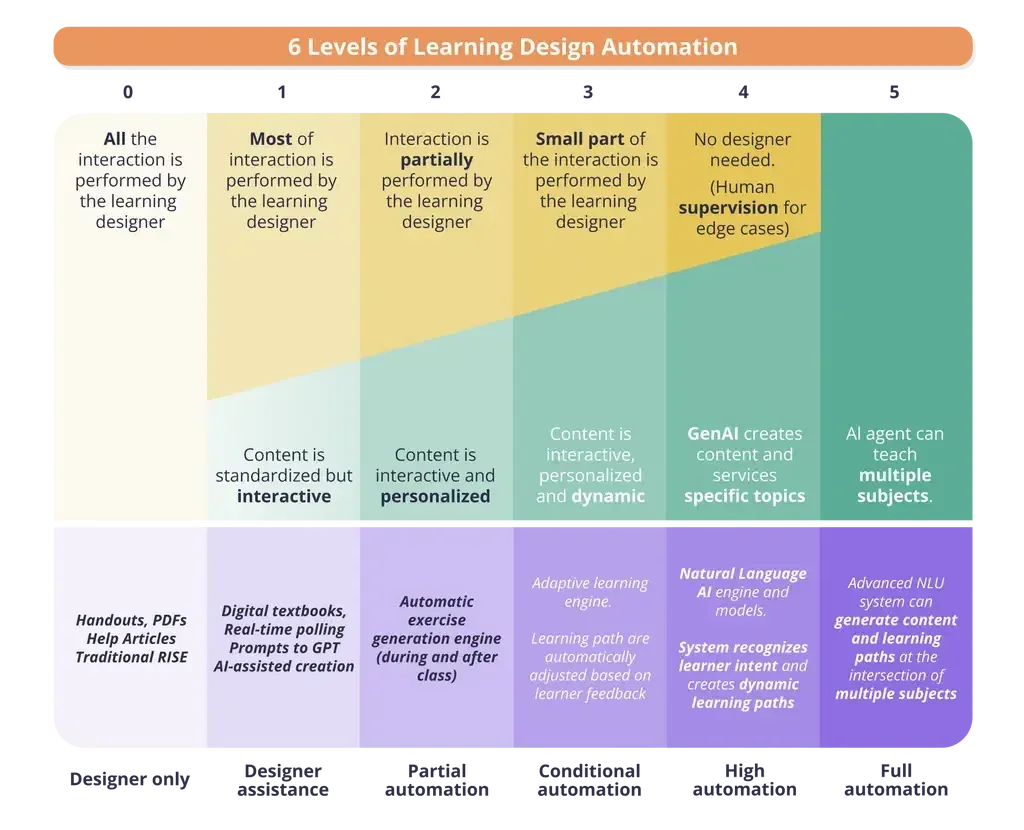

Quando si introduce l’IA nella propria organizzazione, è importante pensare all’intersezione tra l’IA e la progettazione dell’apprendimento guidata dall’uomo. Come illustra la tabella, man mano che si cercano livelli più profondi di automazione, c’è una scala mobile tra l’uomo e la macchina per quanto riguarda il controllo, la personalizzazione e i risultati.

A sinistra, si ha una mano pesante di controllo nei confronti del sistema che si sta utilizzando. Le azioni e le decisioni saranno guidate dal content o instructional designer e i miglioramenti e l’automazione dell’IA saranno al massimo limitati. Man mano che ci si sposta verso destra, tuttavia, un maggior grado di azioni e decisioni viene lasciato al sistema IA. In cambio, si ottiene una maggiore profondità di personalizzazione, modularità, automazione, risparmio di tempo e scalabilità del programma di apprendimento.

I vantaggi di un’automazione più profonda vanno oltre gli elementi sopra elencati. Per la maggior parte delle funzioni aziendali, esiste sempre una certa quantità di lavoro manuale ripetitivo o di attività che interferiscono con la produttività. Può trattarsi di riassumere o riorganizzare i dati. Potrebbe trattarsi di scrivere domande per i quiz. Potrebbe essere quella volta in cui avete dovuto passare ore e ore a rietichettare i metadati perché avevano incasinato una tabella.

La fatica è una parte invisibile e insidiosa della vostra vita lavorativa che l’intelligenza artificiale può gestire con facilità. Se trascorrete il 20% della vostra giornata a lottare con un lavoro noioso, l’IA può aiutarvi a recuperare quel tempo e aiutarvi ad andare avanti o, a volte, semplicemente a recuperare.

Nulla di tutto questo, però, accade al livello 1 della tabella precedente. Per recuperare il vostro tempo e delegare all’IA, dovete prima capire il problema che state cercando di risolvere e poi trovare una soluzione (mi piace la selezione dei contenuti basata sull’apprendimento automatico, l’analisi dei dati, la mappatura delle competenze basata sull’IA o gli strumenti di creazione di contenuti dell’IA generativa) che affronti quel problema.

Parlando di IA generativa, è il momento giusto per spiegare cos’è e come funziona ad alto livello.

L’IA generativa (GenAI) spiegata

Prima dell’IA generativa, l’intelligenza artificiale era tipicamente specializzata nel riconoscimento e nella previsione. Poteva trattarsi di trasformare i ghirigori di un documento scansionato in testo modificabile, o di prendere un file audio e trascrivere le parole dalle onde sonore. Sulle tastiere degli smartphone, l’intelligenza artificiale di base può tentare di prevedere o indovinare la parola successiva. Con l’IA generativa, invece, l’intelligenza artificiale crea cose in base a modelli che riconosce nei dati di partenza.

Lo sapevate che

L’IA generativa è in grado di scrivere un sonetto nello stile di William Shakespeare. Shakespeare era incredibilmente coerente e il fatto che abbia messo il suo nome sulla maggior parte dei sonetti che ha scritto lo aiuta. GenAI può anche creare arte nello stile di Vincent Van Gogh. Questo apre una vasta gamma di possibilità eccitanti, ma anche considerazioni etiche sul copyright degli artisti le cui opere finiscono per essere utilizzate in questi modelli di IA senza un esplicito consenso.

Nel suo nucleo, GenAI sfrutta i modelli di IA per l’apprendimento profondo per studiare vaste librerie di dati. Potrebbe trattarsi di ogni immagine e testo scritto di pubblico dominio, di tutti i social media pubblici, di articoli di cronaca e altro ancora. Man mano che le aziende di IA alimentano i loro modelli con un numero maggiore di dati, la precisione e l’affidabilità di questi modelli aumentano. Man mano che acquisisce i dati, inizia a riconoscere gli schemi. Questi schemi possono includere cose che gli esseri umani danno per scontate, o che mi piace conoscere.

Ad esempio, il modo in cui la luce dovrebbe rimbalzare sull’occhio di una persona in una fotografia. Potrebbe essere la struttura prevedibile in cui rientrano i nomi e i verbi nella maggior parte delle frasi. Potrebbe anche essere il modo corretto di pronunciare “enfasi”. Si tratta di schemi a cui non pensiamo consapevolmente, ma che riconosciamo immediatamente se qualcosa non è come ce lo aspettiamo. Dopo l’addestramento su milioni, se non miliardi, di documenti, immagini e video, si è scoperto che l’IA è in grado di riconoscere anche questi schemi, soprattutto se tutto ciò che le viene fornito è coerente con il modo in cui fa queste cose.

L’IA generativa interpreta la coerenza di questi schemi come un’aspettativa di ciò che gli esseri umani fanno e si aspettano di vedere. Per molti versi, vuole solo darci quello che vogliamo. Dobbiamo semplicemente essere intenzionali riguardo ai dati utilizzati per addestrare l’IA, al momento in cui li elabora e alla fine di tutto ciò, spesso otteniamo qualcosa di molto, molto vicino a ciò che ci aspettavamo o che avremmo potuto fare noi stessi.

Ecco un suggerimento

Non siete sicuri che l’immagine che state guardando sia reale o generata dall’IA? Se c’è una persona, controllate le sue mani. I dati di riferimento per le mani sono in genere limitati nei modelli di generazione di immagini non specializzate e spesso sono una delle prime cose che appaiono strane o strane. Se in un’immagine sono presenti testi o loghi, osservateli da vicino per vedere se appaiono innaturali. Il testo generato dall’IA può apparire pixelato o allungato e i loghi possono essere alterati.

Potenziali problemi con le soluzioni di IA

L’IA può piacere un po’ come la magia. Si possono ottenere risultati senza sapere o capire come l’IA li abbia ottenuti. Questo non va bene. Non siamo a Oz. Dobbiamo prestare attenzione a ciò che accade dietro il sipario o, nel caso dell’IA, a ciò che accade all’interno della scatola nera.

01 Il problema della scatola nera

Come ha sottolineato il filosofo francese Bruno Latour, “più la scienza e la tecnologia hanno successo, più diventano opache e oscure”. Questo è particolarmente vero per l’apprendimento automatico, dove spesso nemmeno i progettisti dell’IA sono in grado di spiegare perché o come l’IA sia arrivata a una decisione.

Questa mancanza di approfondimenti viene definita “problema della scatola nera”. Si riferisce alla sfida di comprendere e interpretare i processi decisionali dei modelli complessi di apprendimento automatico, che spesso operano con meccanismi interni intricati e difficili da spiegare o prevedere.

Il problema della scatola nera si basa su alcuni aspetti chiave:

Mancanza di trasparenza: le reti neurali profonde che alimentano l’IA generativa, ad esempio, sono composte da molti strati e parametri (spesso miliardi). Spesso non è chiaro come ogni parametro influenzi il risultato finale. (Anche se il sistema si spiegasse da solo, non si avrebbe il tempo di capire il suo processo decisionale prima di morire). Questa mancanza di trasparenza rende difficile determinare come il modello sia arrivato a una specifica decisione.

Complessità: i modelli di apprendimento automatico sono in grado di catturare schemi e relazioni intricate nei

dati, ma questi modelli possono essere troppo complessi per la comprensione umana. I modelli potrebbero utilizzare caratteristiche o connessioni che non sono immediatamente evidenti all’uomo (mi piace che ci siano pregiudizi impliciti o omissioni nei dati raccolti).

Difficoltà nella risoluzione dei problemi: quando un modello di IA commette un errore o una decisione distorta, può essere difficile identificare la causa principale, con conseguenti difficoltà nel debugging e nel miglioramento del sistema.

Problemi etici: in alcune applicazioni in cui l’IA viene utilizzata per prendere decisioni critiche (mi piace la finanza, la sanità o le questioni legali), il problema della scatola nera solleva problemi etici. Le parti interessate non dovrebbero fidarsi delle decisioni prese da modelli che non possono interpretare o spiegare.

Affrontare il problema della scatola nera è un’area di ricerca e sviluppo in corso nell’IA. I ricercatori stanno lavorando su metodi per migliorare l’interpretabilità e la trasparenza dei modelli, ad esempio creando tecniche per visualizzare il comportamento dei modelli, l’importanza delle caratteristiche e i razionali delle decisioni. Questo è particolarmente importante per garantire l’equità, la responsabilità e la trasparenza dei sistemi di IA nelle applicazioni reali. (Approfondiremo questo aspetto nella sezione Quadri per un’IA di successo).

02 Allucinazioni

L’IA ha fatto molta strada. Ma è tutt’altro che perfetta.

I modelli di IA possono generare o produrre informazioni, contenuti o output che non si basano su dati reali o sulla conoscenza del mondo reale. Questo fenomeno è noto come allucinazione e può variare da piccole incongruenze a imprecisioni di fatto fino a vere e proprie invenzioni. Poiché sono generalmente coerenti e grammaticalmente corrette, le allucinazioni possono essere molto convincenti e possono essere scambiate per fatti o ritenute accurate.

Le allucinazioni nei modelli di IA possono essere dovute a vari fattori, tra cui errori o distorsioni nei dati di addestramento, complessità del modello, mancanza di controllo e supervisione durante l’addestramento o il prompt stesso. Nell’elaborazione del linguaggio naturale, ad esempio, i modelli di linguaggio a volte generano testi che sembrano coerenti ma che sono completamente inventati e privi di basi fattuali. Ad esempio, un modello di linguaggio potrebbe generare un paragrafo di testo che descrive un evento o uno scenario fittizio come se fosse reale.

03 Bias nell’IA

I bias nell’IA si riferiscono alla presenza di pregiudizi ingiusti e scorretti nelle decisioni o nelle previsioni fatte dai sistemi di intelligenza artificiale. Questi pregiudizi possono derivare da varie fonti e possono portare a risultati discriminatori o diseguali.

Anche se la posta in gioco non è così alta nell’apprendimento come nella sanità o nella giustizia penale, i pregiudizi possono comunque compromettere i programmi e manifestarsi nei seguenti modi:

Pregiudizio dei dati di addestramento: una delle principali fonti di pregiudizio nell’IA è rappresentata dai dati di addestramento distorti. Se i dati utilizzati per addestrare un modello di IA contengono pregiudizi (ad esempio storici, di campionamento, per procura, ecc.) o riflettono le disuguaglianze e gli stereotipi esistenti nella società, è probabile che il modello apprenda e perpetui tali pregiudizi. Progettare un sistema in modo che produca esempi equilibrati dal punto di vista del genere (indipendentemente dalla divisione di genere esistente negli esempi su cui è stato addestrato) contrasterebbe questo fenomeno.

Pregiudizio algoritmico: alcuni algoritmi possono intrinsecamente favorire un gruppo o produrre risultati distorti a causa del modo in cui elaborano i dati. Un sistema di riconoscimento facciale, ad esempio, potrebbe essere meno accurato per le persone con la carnagione più scura, o un sistema di riconoscimento vocale potrebbe non funzionare bene con i dialetti regionali.

Pregiudizi di etichettatura: le persone responsabili dell’etichettatura possono introdurre inconsciamente i loro pregiudizi quando etichettano immagini o testi. Come discusso in precedenza, l’IA vuole semplicemente soddisfare le aspettative degli esseri umani, definite dai modelli presenti nei dati di partenza. Pertanto, tutti i pregiudizi rappresentati nell’etichettatura umana saranno riportati nell’output statistico del sistema IA. Il sistema ha imparato a mantenere esattamente la stessa quantità di pregiudizi di un umano, il che può essere problematico.

Cicli di feedback: l’ IA non impara solo dal suo set di dati, ma anche dall’interazione con gli esseri umani. Se gli utenti si impegnano costantemente o forniscono feedback positivi su contenuti distorti, il sistema di IA può adattarsi e rafforzare questi pregiudizi. In altre parole, i sistemi di IA che interagiscono con gli utenti possono imparare i pregiudizi dalle loro interazioni.

Nel contesto dell’IA per l’apprendimento, i pregiudizi sono un rischio enorme da tenere presente. Non esistono due utenti uguali. Esiste un livello di implementazione efficace dell’IA che apporta un grado di personalizzazione basato sulle caratteristiche uniche di ciascun utente, sfruttando al contempo i dati raccolti all’interno della piattaforma di formazione. La combinazione di queste due strategie può consentire all’IA di adattarsi alle esigenze di un utente a livello individuale.

Attenuare i pregiudizi nell’IA per l’apprendimento è fondamentale per garantire che i sistemi siano equi, etici e imparziali nelle loro decisioni e che l’esperienza di apprendimento sia personalizzata per l’individuo (senza pregiudizi nei suoi confronti).

Lo sapevate che

Secondo un recente sondaggio, l’86% degli utenti intervistati ha sperimentato allucinazioni da IA quando ha utilizzato chatbot come ChatGPT e Bard. Nonostante ciò, il 72% si fida ancora dell’IA.

Quadri di riferimento per un’IA di successo

Non esiste una soluzione rapida per il problema della scatola nera, delle allucinazioni, dei pregiudizi e di altri problemi inerenti all’IA, ma fortunatamente ci sono molte persone e organizzazioni intelligenti che stanno lavorando a questo problema. Durante lo sviluppo di soluzioni basate sull’IA, il team di Docebo ha scavato a fondo nella propria ricerca e ha trovato questi principi, tecniche e framework utili per pensare a soluzioni efficaci, incentrate sull’utente e affidabili.

01 Ispezionabile, spiegabile, sovrascrivibile

Nel report del Dipartimento dell’Istruzione degli Stati Uniti, Office of Educational Technology, IA and the Future of Teaching and Learning, gli authoring IA delineano i criteri per i “buoni modelli di IA” e introducono l’idea che un’IA efficace per l’apprendimento deve essere tre cose: Ispezionabile, spiegabile e sovrascrivibile.

Ispezionabilità: si riferisce alla capacità dell’utente di monitorare il funzionamento interno dell’IA nel prendere decisioni e creare risultati.

Spiegabilità: si riferisce alla capacità di fornire spiegazioni leggibili per le decisioni prese dai modelli di IA.

Sovrapponibilità: si riferisce alla capacità dell’utente di sostituire o rimuovere elementi dell’output o del processo decisionale dell’IA per avere un maggiore controllo sull’output finale.

Insieme, questi principi di sviluppo dei prodotti IA forniscono la trasparenza e il controllo di cui l’uomo ha bisogno per poter convalidare e adattare le decisioni del modello IA, se necessario. Se si prevede che l’utente ceda il controllo delle azioni e delle decisioni all’automazione, questi principi aiutano a preservare il controllo generale sull’output del sistema. In questo modo è possibile beneficiare dell’IA senza dover avere una fiducia cieca nel sistema.

02 Generazione aumentata del recupero (RAG)

Un altro modo in cui gli sviluppatori possono migliorare l’affidabilità dei risultati di un modello di IA è una strategia chiamata Retrieval Augmented Generation (RAG).

RAG è un framework IA che utilizza una base di conoscenza affidabile per migliorare i modelli di linguaggio di grandi dimensioni (LLM). Recupera fatti accurati per migliorare il processo di generazione e garantisce che il contesto sia basato sulle informazioni più recenti.

Ricordate: i parametri e i dati inizialmente inseriti in un modello IA sono statici e per aggiornarli è necessario riqualificare il modello. Il RAG permette ai modelli di linguaggio di saltare la riqualificazione e di accedere a informazioni aggiornate e affidabili. Questo approccio non solo aumenta l’attendibilità delle informazioni fornite, ma riduce anche la probabilità di creare contenuti falsi o fuorvianti, rendendola una tecnica preziosa per le applicazioni in cui l’accuratezza dei fatti e il contesto sono fondamentali.

I sistemi di IA per l’apprendimento più efficaci e personalizzati si collegheranno e attingeranno alla base di conoscenze interne ed esterne dell’azienda per garantire che i contenuti di apprendimento siano non solo completi, ma anche specifici per la vostra attività. Ma per essere efficaci, è necessario fare ordine in casa perché, come si suol dire, chi non entra non esce.

Un’enfasi sulla gestione della conoscenza

La maggior parte dei manager L&D comprende già l’importanza vitale della gestione della conoscenza; tuttavia, a volte mi piace una battaglia in salita per creare un allineamento interfunzionale in tutta l’azienda su quello che è essenzialmente un progetto a livello aziendale.

Il risultato di qualsiasi modello di IA è buono solo quanto la qualità dei dati. E quando i dati a cui fanno riferimento RAG e la vostra soluzione di IA sono la base di conoscenza interna ed esterna dell’azienda, la gestione della conoscenza diventa fondamentale per tutti i membri dell’organizzazione.

La base di conoscenze a cui si fa riferimento funge da spina dorsale per il fact-checking e la convalida, consentendo al modello di generare informazioni accurate e affidabili. Se questa base di conoscenze (le conoscenze dell’organizzazione) è vecchia, incompleta o imprecisa, il processo RAG può portare alla diffusione di informazioni errate o non aggiornate.

Se state investendo in un prodotto di IA che farà riferimento alla vostra base di conoscenze, la gestione delle conoscenze sarà fondamentale per garantire la qualità e la pertinenza dei risultati.

Considerate la possibilità di creare (o ricostruire) un team interfunzionale per la gestione della conoscenza nella vostra azienda. Il team dovrebbe coinvolgere i seguenti gruppi e qualsiasi altro gruppo specifico della vostra azienda che sia fondamentale per la definizione delle verità:

- Prodotti

- Marketing dei prodotti

- Legale

- Abilitazione

- Knowledge Management / Help Desk manager

03 Riduzione del rischio attraverso la pedagogia

Supponiamo, ad esempio, di adottare un’IA per l’apprendimento il cui modello è stato addestrato sulla maggior parte di internet e dei corsi gratuiti (e forse alcuni premium) disponibili. Dovete porvi alcune domande scomode:

- Questi corsi sono validi o pedagogicamente validi?

- I dati di formazione e i modelli che alimentano l’IA rappresentano il livello che ho stabilito per i miei programmi di apprendimento?

- Si può mai sapere se un corso è efficace senza vedere anche come gli utenti si sono comportati e hanno mantenuto le lezioni?

Quando si parla di IA per l’apprendimento, la più grande forza dell’IA può anche rappresentare una delle sue più grandi vulnerabilità. Quando un modello si basa sugli schemi presenti nei dati di addestramento, non può prendere decisioni ricche di contesto che siano in disaccordo con tali schemi. Una biblioteca di teorie sull’apprendimento non fa di una persona un professionista dell’apprendimento o un maestro facilitatore.

Senza comprendere anche i risultati specifici degli utenti dopo un programma di formazione, la comprensione dell’IA generativa basata su modelli per la creazione di contenuti didattici si basa solo sull’efficacia teorica di un corso, e la maggior parte dei professionisti L&D sa quanto rapidamente un programma di apprendimento possa perdere la sua strada quando l’utente non è al centro della sua progettazione.

Quando la pedagogia incontra l’IA

Un modello o quadro pedagogico integrato è il perno di un’IA efficace per l’apprendimento. Colma il divario tra le capacità tecnologiche dell’IA e l’efficacia educativa allineando il modello dell’IA con le teorie e le pratiche educative consolidate. Fornisce i principi e i quadri fondamentali necessari per creare esperienze educative efficaci, coinvolgenti e d’impatto. Il che è importante, perché maggiore è l’impatto dell’esperienza di apprendimento, maggiore sarà l’impatto dell’apprendimento sulla vostra azienda. (Perché, come tutti sappiamo, l’apprendimento non è solo un fattore di crescita personale, ma anche di crescita aziendale).

L’integrazione di strategie pedagogiche può migliorare la qualità dell’esperienza di apprendimento, fornendo contenuti personalizzati, allineati agli obiettivi, coinvolgenti, misurabili e personalizzati e guidando i processi di IA per garantire che gli obiettivi di apprendimento siano raggiunti in modo efficiente ed efficace.

04 Sistemi Human-in-the-loop (HILT)

Ci sono probabilmente molti compiti a basso rischio che dovremmo affidare completamente all’intelligenza artificiale, senza mai voltarci indietro. Lo abbiamo sempre fatto con la tecnologia. (Nessuno gestisce più manualmente il centralino telefonico della città, vero?).

Tuttavia, continuano a esistere una serie di compiti e funzioni importanti che richiederanno sempre la presenza di un uomo nel ciclo (HILT). Se guardiamo al di fuori dell’apprendimento e a qualcosa di fondamentale importanza come il cibo, vediamo che l’IA è già presente in agricoltura. Dal rilevamento delle erbe infestanti all’analisi della crescita, fino al monitoraggio della salute, i modelli di apprendimento automatico stanno aiutando ad aumentare e migliorare il modo in cui coltiviamo il cibo e nutriamo la nostra gente. Ma questo non significa che non abbiamo o non avremo ancora bisogno di agricoltori che prendano decisioni cruciali su sistemi critici. Anche l’apprendimento è fondamentale e, a prescindere dai notevoli miglioramenti dell’intelligenza artificiale, richiederà sempre un sistema umano.

I sistemi di IA fanno previsioni e prendono decisioni, ma raramente lo fanno con una fiducia del 100% o con una certezza assoluta. In effetti, il concetto di certezza assoluta è molto umano. Ecco perché i sistemi e i processi HILT sono fondamentali. Svolgiamo un ruolo centrale nel gestire le sfumature e i fattori contestuali che l’IA potrebbe non cogliere appieno, trovando in definitiva un equilibrio tra approfondimenti guidati dall’IA e saggezza umana.

Le soluzioni IA più potenti non elimineranno la necessità di interazione umana. Le soluzioni di IA più potenti non elimineranno la necessità dell’interazione umana, ma la renderanno possibile in ogni fase, in modo da poter convalidare e supervisionare i risultati (nel contesto più ampio in cui il modello di IA opera), fornire feedback e indicazioni e applicare un giudizio etico e morale alle decisioni.

Lo sapevate che

Andragogia o Pedagogia? L’andragogia si riferisce alle migliori pratiche e ai metodi sostenuti dalla ricerca per insegnare agli utenti adulti, mentre la pedagogia si riferisce tipicamente alle migliori pratiche e ai metodi sostenuti dalla ricerca per insegnare ai bambini. Tuttavia, la pedagogia è spesso usata in un contesto ampio per descrivere metodi sia per gli adulti che per i bambini (ad esempio, i college e le università spesso usano la pedagogia piuttosto che l’andragogia). Quando usiamo il termine pedagogia, è in senso lato e riconosce che i nostri utenti sono adulti.

Dai processi umani alle strutture IA

Che si lavori con la grafica, l’authoring o l’instructional design, c’è un processo creativo dietro il vostro mestiere. Questi processi sono ripetibili, situazionali e fondamentali per i tipi di artefatti che create. Possono anche essere replicati e addestrati a un’IA per migliorare il vostro flusso di lavoro, restituendovi il tempo per concentrarvi su decisioni strategiche più ampie. Meno fatica, più produttività.

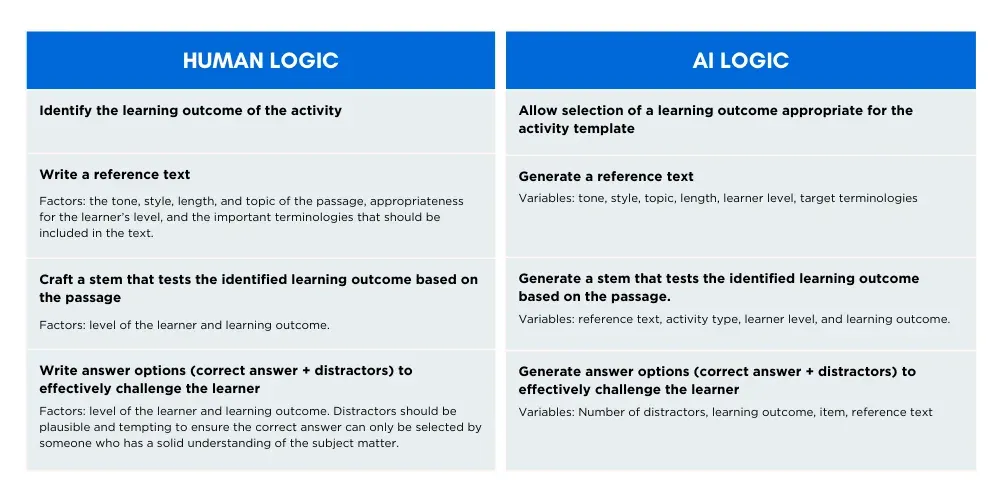

Il diagramma seguente esamina un modo per tradurre alcune delle decisioni strategiche che un instructional designer prende durante la stesura delle domande a scelta multipla (MCQ) in un framework che l’IA può seguire per fornire risultati simili o migliori in una frazione di tempo.

Durante la stesura delle domande a risposta multipla, i progettisti didattici tengono conto di diversi fattori che influenzano la qualità della valutazione.

Utilizzando la metodologia di Docebo, catturiamo tutti questi fattori e li utilizziamo come variabili di input per generare un output che racchiude tutte queste decisioni altrimenti umane. Si noti che la sequenza delle decisioni è anche in linea con l’ordine del processo di authoring umano e con le dipendenze di ogni decisione. Ad esempio, quando si scrive un’attività di comprensione della lettura, gli authoring umani scrivono prima il testo di riferimento, poi lo stem (la domanda) e infine le opzioni. Questo è esattamente l’ordine in cui le catene di prompt verranno eseguite nel processo di generazione.

L’IA di oggi per l’apprendimento ha ancora bisogno di essere guidata dall’autore. Per questo motivo, i prodotti di apprendimento più efficaci avranno alle spalle metodologie umane (come quella illustrata sopra) che consentiranno loro di pensare e prendere decisioni come un instructional designer.

I prossimi passaggi

Ora che ne sapete di più sull’IA per l’apprendimento, siete pronti per iniziare la vostra ricerca. Ma prima di iniziare, vi suggeriamo di rispondere a queste sei domande che vi aiuteranno a guidare voi e il vostro team nella valutazione dei potenziali fornitori e nell’acquisto di prodotti per l’IA.

6 domande importanti a cui rispondere prima di contattare i fornitori

- Che cosa sta guidando la vostra decisione d’acquisto? L ‘acquisizione di questo prodotto si basa sulla soluzione di un problema esistente o avete un budget residuo e la demo era brillante?

- Che impatto avrà sull’esperienza dell’utente? Il prodotto si basa sul comportamento dell’utente esistente o prevede che gli utenti imparino nuove competenze? (E cosa significa questo per l’onboarding e il time-to-value)?

- Chi ha il controllo dei dati e dei processi? Chi decide quali dati sono rilevanti per il modello IA? Dove verranno archiviati ed elaborati i dati?

- Come si evita il problema della scatola nera? È possibile ispezionare, spiegare o annullare le decisioni del modello di IA, se necessario?

- L‘apprendimento è al centro del modello di IA? Il riconoscimento dei modelli guiderà la creazione di materiali didattici o sono integrate strategie pedagogicamente efficaci per guidare i processi di IA?

- Come gestirete questo prodotto? I prodotti di intelligenza artificiale (IA) si basano sulla qualità dei loro input. Come si farà a garantire che i contenuti che consuma siano reali, rilevanti e affidabili?

Informazioni su Docebo IA

Crediamo che l’intelligenza artificiale offra una delle più potenti opportunità di innovazione nel campo dell’apprendimento e dello sviluppo. Come leader in questo spazio, non seguiamo le tendenze, le creiamo. La piattaforma Docebo per l’apprendimento è alimentata dall’intelligenza artificiale, con diverse funzionalità IA incluse nel sistema per migliorare il modo in cui aziende e imprese distribuiscono, gestiscono e scalano i loro programmi di apprendimento.

Ecco alcuni principi guida di come pensiamo all’IA nei nostri prodotti e servizi, e cosa potete aspettarvi da Docebo IA.

Un approccio basato sulla pedagogia: quando si parla di apprendimento e sviluppo, un framework IA che non includa la pedagogia e le best practice consolidate nell’insegnamento e nell’apprendimento non è sufficiente. Il nostro team di prodotti per l’IA comprende esperti di pedagogia che utilizzano un approccio pedagogico per progettare le nostre soluzioni di IA al fine di massimizzare i risultati per gli utenti, riducendo al minimo le allucinazioni e i risultati imprecisi.

Valutazione continua: stiamo costruendo un volano di apprendimento continuo e di valutazione solida per aiutare a informare i nostri modelli di IA. Quando i modelli di IA si basano esclusivamente sul riconoscimento e sulla replica dei modelli, i risultati non sono adatti all’apprendimento dei contenuti. Comprendendo e sfruttando le prestazioni dell’utente attraverso integrazioni di valutazione, il flusso di apprendimento non viene mai interrotto e viene mantenuta una prospettiva più completa. L’IA di Docebo è collegata al quadro generale e fornisce la spina dorsale fondamentale per l’apprendimento iperpersonalizzato / iperpersonalizzazione.

Verso un apprendimento individualizzato: l’iperpersonalizzato / iperpersonalizzazione e l’apprendimento nel flusso di lavoro sono risultati inevitabili dell’IA nell’apprendimento. In Docebo, siamo concentrati sulla realizzazione di questi risultati per i nostri clienti attraverso l’implementazione intelligente di un’IA sicura ed efficace.

Ispezionabile, Spiegabile, Sovrapponibile: una soluzione efficace di IA per l’apprendimento non elimina mai l’uomo dal processo e dai suoi risultati. In Docebo, progettiamo con ispezionabilità, spiegabilità e sovrascrivibilità al centro dei nostri prodotti e servizi, consentendo all’utente di avere il controllo e la fiducia nel proprio lavoro.

Liberare l’utente per concentrarsi su ciò che conta: l ‘intento di Docebo è quello di progettare soluzioni di IA per l’apprendimento che scarichino gran parte del lavoro ripetitivo e dispendioso in termini di tempo, in modo che i progettisti dell’apprendimento possano concentrarsi su ciò che conta davvero, come l’interpretazione dei dati, la governance dei contenuti, il processo decisionale strategico e la progettazione olistica dell’apprendimento.

Controllo: le organizzazioni devono avere il controllo del funzionamento dell’IA all’interno del proprio business. Le soluzioni di Docebo offrono alle aziende il controllo sui propri dati, in modo che possano decidere come (e se) utilizzarli. Forniamo anche l’anonimizzazione dei dati sul nostro LLM per garantire la privacy e il controllo dei dati.

Collaboratori

Michael Chong

Scienziato senior (Docebo)

Rebecca Chu

Analista di apprendimento automatico (Docebo)

Vince De Freitas

Product Marketing Manager, Content & IA (Docebo)

Maija Mickols

Product Manager IA (Docebo)

Giuseppe Tomasello

Vicepresidente IA (Docebo)

Renee Tremblay

Senior Content Marketing Manager, (Docebo)